本文来自微信公众号“半导体产业纵横”。

全球科技巨头纷纷下场卷向AI芯片赛道。

2023年,“生成式人工智能”无疑是科技行业最热门的术语。

OpenAI推出的生成应用ChatGPT引发了市场狂热,促使各科技巨头纷纷加入竞争。

据TechNews报道,目前NVIDIA通过提供AI加速器占据市场主导地位,但这导致了市场上其AI加速器的短缺。甚至OpenAI也打算开发自己的芯片,以避免受到供应链紧张的限制。

在当前的AI发展浪潮中,NVIDIA无疑是AI算力的领跑者。其A100/H100系列芯片已获得全球人工智能市场顶级客户的订单。

华尔街投资银行Bernstein Research的分析师Stacy Rasgon表示,使用ChatGPT进行的每次查询的成本约为0.04美元。如果ChatGPT查询规模扩大到Google搜索量的十分之一,初始部署将需要价值约481亿美元的GPU进行计算,每年需要价值约160亿美元的芯片来维持运营,以及类似的相关芯片执行任务的数量。

因此,无论是为了降低成本、减少对NVIDIA的过度依赖,甚至是进一步增强议价能力,全球科技巨头都启动了开发自己的AI加速器的计划。

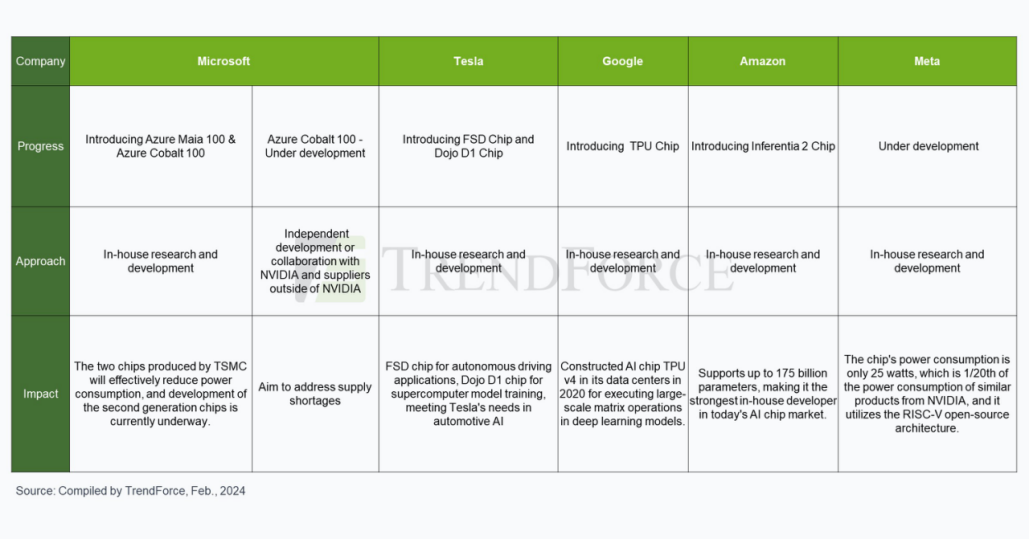

据科技媒体The Information援引行业消息人士报道,微软、OpenAI、特斯拉、谷歌、亚马逊和Meta等六大全球科技巨头都在投资开发自己的AI加速器芯片。这些公司预计将与NVIDIA的旗舰H100 AI加速器芯片展开竞争。

科技巨头自研芯片进展

微软

2023年11月,微软在年度IT专业人士和开发者大会Ignite上推出两款自研芯片——云端AI芯片微软Azure Maia 100、服务器CPU微软Azure Cobalt 100。

Maia 100是微软为微软云中大语言模型训练和推理而设计的第一款AI芯片,采用台积电5nm工艺,拥有1050亿颗晶体管,针对AI和生成式AI进行了优化,支持微软首次实现的低于8位数据类型(MX数据类型)。微软已经在用搜索引擎Bing和Office AI产品测试该芯片。

Cobalt 100是微软为微软云定制开发的第一款CPU,也是微软打造的第一款完整的液冷服务器CPU,采用Arm Neoverse CSS设计、128核。

微软还定制设计了一个AI端到端机架,并搭配了一个“助手”液冷器,原理类似于汽车散热器。

两款芯片明年年初开始在微软数据中心推出,最初为微软的Copilot或Azure OpenAI Service等服务提供动力。微软已经在设计第二代版本的Azure Maia AI芯片和Cobalt CPU系列。

这些芯片代表了微软交付基础设施系统的最后一块拼图——从芯片、软件和服务器到机架和冷却系统的一切,微软这些系统都是由上到下设计的,可以根据内部和客户的工作负载进行优化。

OpenAI

据悉,OpenAI也正在探索自研AI芯片,同时开始评估潜在收购目标。在其招聘网站上,最近也出现了AI硬件共同开发、评估相关岗位。OpenAI拟筹建的合资企业与总部位于阿布扎比的G42和软银集团等潜在投资者进行了讨论,旨在解决当前和预期的人工智能相关芯片供应短缺问题。

毫无疑问,该项目的财务和运营规模显然是巨大的。Altman仅与G42的讨论就集中在筹集80亿至100亿美元之间。该项目的全部范围和合作伙伴名单仍处于早期阶段,这表明建立此类设施网络需要大量投资和时间。

尽管还不清楚Altman是否计划购买一家成熟的代工厂来生产AI芯片,或建立一个全新的晶圆厂网络来满足OpenAI及其潜在合作伙伴的需求,但此前有人分析Altman可能会考虑把参与投资的芯片公司纳入麾下,包括CerebrasRain NeuromorphicsAtomic SemiCerebras、Rain Neuromorphics、tomic Semi。

特斯拉

电动汽车制造商特斯拉也积极参与AI加速器芯片的开发。特斯拉主要围绕自动驾驶需求,迄今为止推出了两款AI芯片:全自动驾驶(FSD)芯片和Dojo D1芯片。

FSD芯片用于特斯拉汽车的自动驾驶系统,而Dojo D1芯片则用于特斯拉的超级计算机。它充当通用CPU,构建AI训练芯片来为Dojo系统提供动力。

谷歌

Google也早在2013年就秘密研发专注AI机器学习算法芯片,并用于云计算数据中心,取代英伟达GPU。

这款TPU自研芯片2016年公开,为深度学习模型执行大规模矩阵运算,如自然语言处理、计算机视觉和推荐系统模型。Google其实在2020年的资料中心便建构AI芯片TPU v4,直到2023年4月才首次公开细节。

2023年12月6日,谷歌官宣了全新的多模态大模型Gemini,包含了三个版本,根据谷歌的基准测试结果,其中的Gemini Ultra版本在许多测试中都表现出了“最先进的性能”,甚至在大部分测试中完全击败了OpenAI的GPT-4。

而在Gemini出尽了风头的同时,谷歌还丢出了另一个重磅炸弹——全新的自研芯片TPU v5p,它也是迄今为止功能最强大的TPU。

根据官方提供的数据,每个TPU v5p pod在三维环形拓扑结构中,通过最高带宽的芯片间互联(ICI),以4800 Gbps/chip的速度将8960个芯片组合在一起,与TPU v4相比,TPU v5p的FLOPS和高带宽内存(HBM)分别提高了2倍和3倍。

除此之外,TPU v5p训练大型LLM模型的速度比上一代TPU v4快2.8倍,利用第二代SparseCores,TPU v5p训练嵌入密集模型的速度比TPU v4快1.9倍。TPU v5p在每个pod的总可用FLOPs方面的可扩展性也比TPU v4高出4倍,且每秒浮点运算次数(FLOPS)增加了一倍,单个pod中的芯片数量也增加了一倍,大大提高了训练速度的相对性能。

亚马逊

亚马逊旗下的云计算服务提供商亚马逊网络服务(AWS),自2013年推出Nitro1芯片以来,它一直是开发自有芯片的先驱。AWS此后开发了自研芯片的三个产品线,包括网络芯片、服务器芯片、AI机器学习芯片。

其中,AWS自研AI芯片阵容包括推理芯片Inferentia和训练芯片Trainium。

此外,AWS于2023年初推出了专为人工智能设计的Inferentia 2(Inf2)。它将计算性能提高了三倍,同时将加速器总内存增加了四分之一。

它通过芯片之间直接超高速连接支持分布式推理,可处理多达1750亿个参数,使其成为当今AI芯片市场上最强大的内部制造商。

Meta

Meta在2022年之前继续使用专为加速AI算法而定制的CPU和定制芯片组来执行其AI任务。然而,由于CPU在执行AI任务方面与GPU相比效率较低,Meta放弃了2022年大规模推出定制设计芯片的计划,而是选择购买价值数十亿美元的NVIDIA GPU。

尽管如此,在其他主要厂商开发内部人工智能加速器芯片的浪潮中,Meta也涉足内部芯片开发。

2023年5月19日,Meta进一步公布了其人工智能训练和推理芯片项目。该芯片功耗仅为25瓦,是NVIDIA同类产品功耗的1/20。它采用RISC-V开源架构。据市场报道,该芯片也将采用台积电的7纳米制造工艺生产。

美国去年10月扩大禁止向中国出售先进人工智能芯片,英伟达虽然迅速为中国市场量身订造新芯片,以符合美国出口规定。但近日有消息指出,阿里巴巴、腾讯等中国云计算大客户,并不热衷购买功能降低的减规版H20芯片,转成国内采购。策略转变显示透过部分先进半导体订单转给中国公司,将更依赖中国本土厂商芯片。

TrendForce表示,中国云端业者约八成高阶AI芯片购自英伟达,五年内可能降至50%~60%。若美国继续加强芯片管制,可能对英伟达中国地区销售造成额外压力。