本文来自微信公众号“与非网eefocus”,作者/张慧娟。

政策与技术的双重驱动下,高效低碳的液冷技术不仅是散热方式的改变,更有可能变革整个数据中心生态。

近日,ChatGPT官网一度停止Plus付费项目的购买,原因是“需求量过大”。业内推测这是由于ChatGPT背后的算力资源出现明显缺口,导致OpenAI不得不暂时踩下用户增长的“刹车”。尽管截止本文发稿时这一服务项目已恢复,但算力告急确是现实情况。

算力催生数据中心规模扩张

高效变革在即

图源|reviewguruu.com

类ChatGPT大模型迅速引爆各类AI应用需求的同时,也对算力提出巨大需求,同时带来了严峻的能源问题,如何实现可持续的算力增长成为未来发展的关键。

以ChatGPT为例,业内对其电量需求进行过相关测算。根据OpenAI公开信息披露,ChatGPT训练阶段总算力消耗约为3640PF-days(即以1PetaFLOP/s的效率运行3640天),对应数据中心装机功率需求2.68万千瓦。据Similarweb数据,截至今年1月,ChatGPT日活约1300万人,每人平均1000字左右的问题,对应运行阶段每日算力消耗约为3000PF-days,对应数据中心装机功率需求66.3万千瓦,对应全年用电量需求约22亿千瓦时。

随着模型迭代、参数量的扩大,以及日活人数的扩大,相关算力需求将成倍增加,也将进一步推升数据中心的规模扩张趋势。

从我国数据中心的发展和建设方向来看,工业和信息化部、发展改革委等七部门联合发布《信息通信行业绿色低碳发展行动计划(2022-2025年)》(以下简称《行动计划》),2025年,全国新建大型、超大型数据中心电能利用效率(PUE)降到1.3以下,改建核心机房PUE降到1.5以下。

另外,根据“东数西算”工程要求,内蒙古、贵州、甘肃、宁夏四处集群枢纽设立的数据中心集群PUE应控制在1.2以内;京津冀、长三角、粤港澳大湾区、成渝四处集群枢纽设立的数据中心集群PUE则要控制在1.25以下。

除了政策层面的严苛要求,技术层面的变革也迫在眉睫:

当前,芯片功耗与服务器功耗逐步上升,特别是人工智能需求的通用GPU功耗急剧增加,使得单机柜功率密度正不断增大。根据《2021-2022年度中国数据中心基础设施产品市场总报告》,2021年我国单机柜功率在10kW以上的数据中心市场规模增速超过10%,其中30kW以上增速达31%。

如果采用风冷散热方式,通常要把单机柜功率控制在12kW以内,以确保散热系统能够为IT设备提供合适的工作温度。但是,随着服务器单位功耗不断增大,单机柜功率15kW基本成为空气对流散热能力的天花板,一旦超越这一数值,处于高温状态工作的IT设备将出现运行不稳、加剧老化甚至频繁宕机等后果。

在政策与技术的双重驱动下,高效低碳的液冷技术不仅是散热方式的改变,更有可能变革整个数据中心生态。

AI服务器液冷渗透率

将更快、更高

什么是PUE?PUE(Power Usage Effectiveness)是用于测量数据中心能源效率的指标,是用数据中心总能耗除以IT设备能耗得来。总能耗包含IT设备能耗和制冷、配电等系统能耗,PUE数值越靠近1说明非IT设备的能耗越少,能效水平越高。

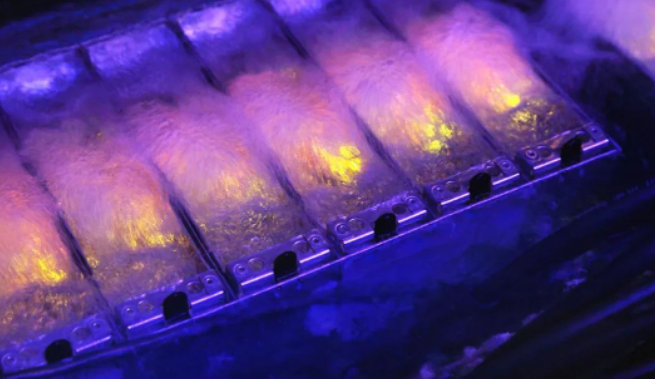

图源|dailyhostnews.com

当前,在PUE目标不断降低,且CPU功耗逐年上升的背景下,业内正在大力推行采用液冷方案来降低服务器整机功耗和数据中心PUE。

所谓液冷,通俗来讲就是通过液体代替空气,把CPU、内存等IT发热器件产生的热量带走,就好似给服务器局部冷却、整体“淋浴”甚至全部浸没。就液冷技术分类而言,根据液体冷媒和发热源的接触方式可分为——冷板式(间接接触)、喷淋式(直接接触)、浸没式(直接接触)。相较于风冷,液冷的优势主要体现在以下方面:

可以带走更多热量。

相较于空气,水的比热容高达4.2x10的三次方焦/千克·摄氏度,导热效率十分高,因此无论是冷板式还是浸没式的液冷,都能带走更多的热量。

噪音品质更好。

作为生产噪音的“专业户”,数据中心机房的噪音往往成为扰民的存在,在同等条件下,液冷的噪音要比风冷小很多。

耗电节能更省。

冷却效率提高的同时,整体循环效率也在变高,这样产品级的电消耗,实际上节约了整个空调系统和循环系统的电耗。

物理占用空间小。

受限于风冷散热系统的限制,迎风面积总是有限的,如果想要实现更高的密度,就需要在单位体积内实现更高的冷却容量,这也是液冷才可以实现的。

宁畅首席技术官赵雷认为,风冷技术的极限值基本是在300W-350W之间,目前数据中心已经慢慢触碰到这个极限值,而随着CPU功耗的增长,推进液冷技术发展已经成为行业发展的重要推动力。

新华三服务器产品线系统部总监郑国良表示,“东数西算”项目正式落地后,对数据中心PUE的要求非常明确,数据中心对于液冷技术需求的迫切性都提到比较高的位置。因此对于当前和下一代平台,包括浸没式液冷都会加大投入和加快发布的进度。

针对当前火爆的AI服务器市场,浪潮信息服务器产品线总经理赵帅表示,“短期内,AIGC对数据中心训练需求是爆炸式的增长。长远来看,推理市场也会是爆炸性的增长”。

相比于通用服务器,AI服务器功耗更高,单台服务器约10千瓦。“现在10千瓦的服务器是6U高,单U要解决1.5千瓦到2千瓦的散热量,如果单纯用风冷技术,需要把服务器做成10U高,几乎不可能实现”,赵帅认为,“液冷技术在AI服务器的渗透率会更快、更高。”

液冷大规模部署面临重重挑战

图源|colocationamerica.com

尽管推动数据中心向液冷发展已经成为行业共识,但是,液冷技术从小规模验证走向大规模量产仍面临挑战:一是缺乏技术行业标准、规范等指引,产业协同度不高,难以标准化适配和部署;二是由于缺乏长周期、大规模部署验证,液冷数据中心的可靠性问题存在一定争议,用户有使用疑虑;三是产业链协同性差,缺乏具备高度整合能力的企业,资源配置效率低、浪费大,产业发展速度受阻。

针对上述挑战,业界头部企业已经开始了技术创新,并通过产业合作推动相关产品标准、验证标准的建立。

例如针对漏液等安全方面的顾虑,浪潮信息首创了液环式真空CDU,可实现仅依靠真空泵通过不同传感器控制几个腔室的功能切换即可实现流体的循环流动,水泵则仅起到辅助提高系统压差作用。这项技术创新,突破了业界目前负压液冷循环系统必须同时依靠真空泵和水泵,才能实现液体循环流动的“定律”,在降低技术成本的同时,也实现了技术极简化,进一步推动冷板式液冷技术的普及。

针对用户对液冷产品规模化部署的疑虑,浪潮信息与京东云联合发布了天枢(ORS3000S)液冷整机柜服务器,它支持冷板式液冷,散热效率提升50%;满足多节点供电需求的同时,通过电源均衡优化技术,可以使电源一直工作在最高效率,相比于分布式电源模式,整体效率提升10%;支持一体化交付,高效运维部署,交付速度提高5-10倍。

阿里云约从2016年开始大规模部署液冷技术。英特尔与阿里巴巴围绕浸入式液冷所面临的材料兼容性、电气信号完整性、芯片散热特性、服务器系统散热特性、服务器及机柜结构设计等课题,展开了深入合作,从处理器定制和服务器系统开发与优化着手,突破芯片功耗墙功耗和冷却两大影响算力提升的关键问题,使得液冷服务器在阿里巴巴数据中心成功大规模部署,在2018年建成首个互联网液冷数据中心,在2020年投产首个5A级绿色液冷数据中心,每年可以节省电能至少达千万级的同时,使得服务器系统的故障率相比风冷服务器下降约53%,有效降低了数据中心总体拥有成本。

宁畅也在与英特尔的合作中,进一步改善了冷板式液冷设计中的漏液检测、材料兼容性、生产工艺等核心技术要点,并在浸没式液冷中的安装运维、液体挥发与渗漏、材料兼容性等难点问题上实现了突破。

不过,在数据中心服务器实施液冷技术毕竟是系统级工程,需要由点到面、循序渐进地推进。就拿高速I/O连接器为例,当整个传输链路置于液冷材料环境时,由于其周围介电常数的变化,传输链路对应的高频参数,譬如阻抗、插损等会受到影响并在一定程度上变差,因此还需要专门在冷却液环境中进行信号完整性测试,便于校准由于环境引入的偏差,使系统信号裕量符合预期。

2025年,液冷渗透率有望超过20%

国内液冷产业总体发展现状如何?赵帅表示,液冷技术本身,及其加工、焊接、产品工艺等已比较成熟。现在迫在眉睫的是打通产业链的工作,形成可批量化、可复制化、可规模化的效应。

浪潮信息数据中心产品部副总经理李金波表示,推进液冷产业化的关键是建立标准,对于液冷部件来说,主要是两类:一类是设计标准,要让所有研究团队通过公认的标准,慢慢形成标准的技术体系;一类是测试标准,要把原来的设计准则在测试环节中一一地实现、被行业所认可,这时整体的标准、规范才能打通。

“中国的液冷发展会是逐步迭代的过程,到2022、2023年液冷渗透率可能只在5%左右,但是到2025年,我们认为会超过20%”,赵帅表示。

总体而言,我国液冷当前的渗透率还较低。从整体现状来看,主要是一些创新型的数据中心在积极应用,东部地区数据中心整体PUE要求较高,液冷使用相对多。此外,不同行业客户对于液冷产品与方案具有多样化需求。

“在国内当前的应用环境下,没有最好的液冷,只有最适合用的液冷,这是我们的一个核心理念”,赵帅谈到。

写在最后

如何高效建设液冷数据中心?这是全产业都在探究的方向。当前不仅需要将各类服务器全面适配液冷方案,更需要在打通算力层面的基础上,提升液冷的产业化能力。毕竟液冷仍处于商业化的初级阶段,产业提速的核心在于标准化建设、产业链整合,从产品技术、生产组织、品质标准等产业要素入手,才能让液冷技术走向更多数据中心。