本文来自微信公众号“AI芯天下”,作者/方文三。

生产大模型并不是终极目标,让它在各行各业中大展拳脚、发挥出实用价值才是最终追求。

基础层是地基,应用层是高度

人工智能产业链主要分为三个层次:基础层、技术层和应用层。

基础层包括AI芯片、智能传感器和云计算等,为人工智能提供数据和算力支持。

在AI产业初期,基础层企业占比最大,达到83%,而技术层和应用层企业分别占5%和12%。

基础层就像是人工智能大楼的地基,而应用层则决定大楼的高度。

在应用层面,智能机器人、无人机等智慧终端有很大潜力,智慧城市、智慧医疗等领域也有很多机会。

据灼识咨询数据,2022年全球AI芯片市场规模达到960亿美元,预计2027年将达到3089亿美元,而中国AI市场规模预计将于2027年达到1150亿美元。

此外,IDC数据显示,到2025年,用于人工智能推理工作负载的芯片将达到60.8%。

AI大模型从生产终将走向应用

大模型就像一个超级智能的厨师,它改变了传统的做饭方式,让我们可以更快、更好、更灵活地品尝到各种美食。

但是,从商业化的角度来看,它仍然需要面对AI落地应用的挑战。

在过去的几年里,有许多AI公司前仆后继,像开拓一条充满荆棘的道路一样,寻找着AI落地的秘诀。

他们发现,对于许多多样化、碎片化的场景来说,边缘计算就像一把打开AI落地应用商业化大门的钥匙。

大模型这种高级AI技术,得落到具体业务里才能发挥出它的价值。

现在,大模型已经成为了AI的新潮流,很多厂商在尝试商业化时都提出了[行业大模型][一行一模]的观点,也就是用大模型来解决这些碎片化场景中的业务痛点。

从这一点来看,边缘计算这个以灵活调度著称的强大助手,将会成为未来大模型广泛落地到各个场景的重要一环。

而那些为边缘计算提供算力的AI推理芯片,也会在这个过程中迎来一次市场扩容的机会。

就像一场盛大的派对即将开始,边缘计算和AI推理芯片都将在这场派对中大放异彩。

推理芯片将成国内大模型的入场券

训练芯片和推理芯片是AI芯片的两大类,它们的功能各有侧重。

训练芯片主要用于训练大模型,注重计算性能,而推理芯片则主要用于模型的推理运算,注重效率和时延、功耗。

现在,国内大模型正处于训练阶段,需要很强的算力支持,所以很多AI公司都把目光放在了训练芯片上,购买大量的GPU算力来训练算法模型。

这也让英伟达成为了万亿市值的神话,他们的H100、H800等芯片非常受欢迎,国内也有华为、寒武纪等厂商在努力追赶。

现在推理芯片成为热门话题,像机器人、无人驾驶汽车这些领域,都离不开推理芯片。

一旦大模型成熟,就会应用到边端设备上,这时就会需要推理芯片。

但是,由于一些不可抗力的因素,现在训练芯片和推理芯片都受到了管制。

所以,AI芯片的国产替代成为了重要议题。

咱们国内现阶段中,得在国产工艺的基础上,研发、流片和商用这些推理芯片,现在国内芯片的技术水平,大概就在14nm这个节点。

但那些千亿级、万亿级别的大模型,推理芯片得有超强的计算能力,还得功耗超低、成本超低,这要求可就到了5nm、2nm的制程工艺了。

燧原科技早早地就在2020年12月发布了云端AI推理加速卡云燧i10,2021年12月又升级到了第二代云端AI推理加速卡云燧i20。

去年8月,商汤科技向港交所递交的IPO文件里,第一次披露了他们自己研发的AI专用算力芯片STPU、边缘端AI芯片、服务器AI推理芯片。

在2021年7月,瀚博半导体在世界人工智能大会上放出了通用云端推理AI芯片SV100系列和VA1通用推理加速卡。

国际环境变幻莫测,使得中国企业越来越难使用海外的先进芯片技术。

在边缘计算场景里,也存在一些痛点,比如算力不集中、算法太长、产品不够标准、规模也参差不齐。

这时候,就需要有更高算力,还要增加更多的内存容量和更大的内存带宽,这样就能存得下、搬得快足够多的数据。

同时,边缘计算对低功耗、低成本的要求更为严格。

除了支持大模型等AI计算任务,AI边缘推理芯片还负责落地应用最后一公里的工作,需要具备强大的通用算力。

现在,云天励飞在国产供应链的帮助下,通过多重创新技术的组合,证明了自主研发的AI芯片也能满足高算力、大内存的大模型推理需求。

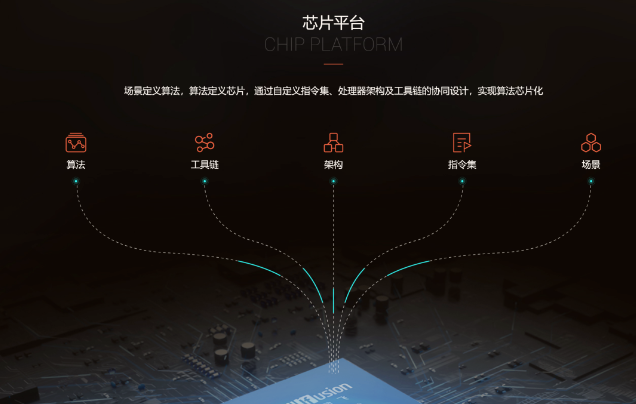

为了满足这些要求,云天励飞自主研发并推出了面向边缘计算全场景、基于国产工艺的大模型推理芯片平台DeepEdge10。

这是国内首创的国产14nm Chiplet大模型推理芯片,采用自主可控的国产工艺,内含国产RISC-V核,支持大模型推理部署。

依托自研芯片DeepEdge10创新的D2D chiplet架构打造的X5000推理卡,已适配并可承载SAM CV大模型、Llama2等百亿级大模型运算,可广泛应用于AIoT边缘视频、移动机器人等场景。

这颗芯片布局了边缘计算的三大芯片平台解决方案:感知计算、视频高密、大模型推理。

结尾:

三年后,80%以上的企业将运行在大模型之上;五年后,机器人和数字人的数量将超过人类的数量;

七年后,大模型的智慧程度将超过人脑,可能拥有超过1万亿的参数体量。

这意味着我们正在进入第四次工业革命的开端。

而现在大家都知道,边缘计算是个大趋势。所以,想要让大模型在未来更好地应用,就得先做好边缘计算的推理芯片。

部分资料参考:雷锋网:《AI推理芯片,大模型「下半场」的入场券》,偲睿洞察:《国产AI芯片,玩家几何》,买方研选:《AI芯片训练+推理芯片调研纪要》

![产业丨AI推理芯片,下一个[群模共舞]的入场券](/uploads/231201/1701411371.png)