本文来自电子发烧友网,作者/周凯扬。

东数西算的提出,不仅是为了建立一个一体化的数据体系,也是一个绿色节能,促进碳达峰、碳中和等目标实现的手段。毕竟在西部地区可以充分发挥可再生能源和环境上的优势,同时减少人口密度高地区的用电紧张。

但东数西算,以及类似的东数西训、东云西库等概念和政策,都只是针对一些对时延并不敏感的应用来说的。然而对于一些要求低时延、大存储容量和大算力的实时应用来说,比如自动驾驶、工业物联网、边缘计算等,仍然需要本地数据中心的支持。但在各大城市纷纷对数据中心的规模加以限制下,如何让中小型数据中心降本增效就成了关键问题。

数据中心是如何成为耗电大户的?

虽然不同的统计口径给出的数据多有不同,但在中国国内,数据中心用电量大概在全社会耗电总量的1.5%到3%左右,可以说是名副其实的“国家电网战略合作伙伴”了。随着现在各行各业对于流量和算力的需求继续上涨,未来这个占比必然会持续走高。

那么究竟是什么让数据中心有着如此庞大的耗电量呢?原因有不少,其中之一是存在于各大数据中心的“僵尸”服务器。利用率是每个数据中心都不得不面临的问题,由于数据中心本身追求大容量,尤其是对于云服务厂商的数据中心来说,有不少服务器都是处于“闲置”状态的。

再加上如今数据中心的架构已经实现了解耦,利用率最高的反倒是网络设备,其次是存储设备,利用率最低的反倒是处理器。这些“僵尸”服务器的存在并不会对其数据中心的运营造成任何不利影响,但它们在闲置的情况下仍会占用电源、空间和散热资源。

虽说现在通过虚拟化等手段已经提高了服务器的利用率,但仍有比较大的提升空间。要知道,从2017年到2022年,国内和地方政策中对大型数据中心的PUE要求就从1.5提升至了1.25,有不少新建的数据中心甚至做到了1.1的PUE。所以未来尽管耗电大户的身份虽然还是不会变,但数据中心必须想尽办法去提升能效比。

数据中心降本增效的解决思路

其实数据中心要想在实现节能的同时,保持性能和容量的增长,方法也相当直接,那就是升级。升级新的冷却系统、变压设备、处理器芯片等,比如取缔或改造升级老数据中心,给IT设备、供电系统、冷却系统都进行彻头彻尾的升级。

就拿处理器芯片的升级来说,虽说数据中心硬件换代的周期并不算短,但要想满足日益增长的算力需求,就不得不用上最新的CPU、GPU和一众AI加速器。可为了想追求极致的能效比,不少数据中心都开始选择基于Arm架构的服务器,而不再是传统的x86服务器,随着Arm在服务器软件生态上慢慢成熟,这一趋势会变得愈发明显。

另一种方式就是用上更高效的服务器电源,随着第三代半导体材料的出现,消费级电源产品的效率已经提升了上来,而服务器电源也能享受这一优势。尤其是基于碳化硅的服务器电源,在应对高压和大功率的场景上,也能轻松达到钛金级别的效率。

冷却系统同样有着极大的降本增效空间,也更加适合“因地制宜”。目前不少数据中心都在选用液冷的方式散热,因为这种方式散热效率高,可以减少传统风冷带来的电力消耗。以中科曙光的全浸式液冷服务器为例,就可以讲PUE值做到趋近于1.0的理论极限。但也有的数据中心为了进一步节省水资源,也想出了新的空气冷却系统。

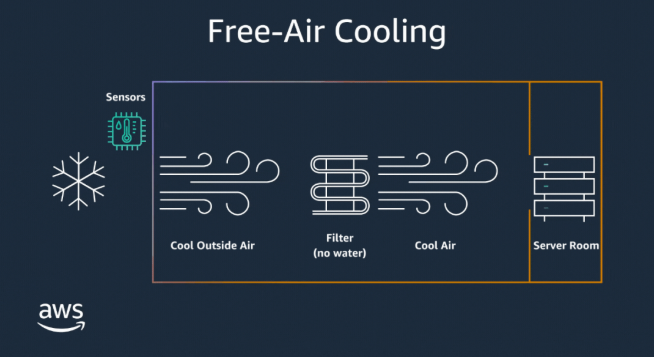

AWS自然空气冷却系统/亚马逊

比如亚马逊的AWS数据中心就主要以蒸发冷却为主,在炎热的天气下,热空气经过过滤器和消耗少量水资源的润湿冷却垫,蒸发产生凉爽的空气来散热。而亚马逊在爱尔兰和瑞典的AWS数据中心,则是靠的自然空气的过滤冷却,因为气温较低的原因,它们一年之中有95%都不是靠水来冷却服务器的。

小结

我们通常将数据中心看做是“算力工厂”,但正如工厂的污染排放监测一样,数据中心的能效也需要持续关注。在各种政策规定下,虽然不少数据中心在建成之际就已经满足了PUE目标,但对于从不停转的数据中心来说,在降本增效的同时,也需要持续公开这些数据,确保不会因为设备老化、负载增加等原因偏离原本的PUE。