情感计算这一概念提出来时不少人对其嗤之以鼻,不少人认为量化情感是一件可笑的事,也有人认为这是推动人工智能进入下一阶段不可或缺的技术。但不论怎么说,这一技术目前并没有普及开来,因为与它相关的应用需要的不仅仅是AI与深度学习,还涉及到了太多其他传感器和心理学的范畴。话虽如此,我们还是陆续看到了情感计算在一些应用中的悄然兴起。

懂情感的机器人

情感计算最贴近我们生活的一项应用自然就是机器人了,目前市面上已经出现了不少基于该技术的服务机器人、陪伴机器人和教育机器人,比如日本软银集团和法国Aldebaran Robotics开发的Pepper。这些机器人的目的除了完成重复性的服务外,也能缓解人们的孤独症或认知障碍等一系列缺陷。且如今仍有不少人被疫情困于家中,这类机器人尤其是陪伴机器人似乎又再度找到了市场。

Pepper机器人/软银

那么这种陪伴机器人用于情感计算的数据从哪来呢?答案就是机器人配备的传感器。这里的传感器并非雷达等用于机器人移动的传感器,而是麦克风、摄像头和手势传感器这类感知人类的传感器。

人的说话速度、音调和响度等参数都暗含了当前的情绪波动,通过深度学习创造出的模型,机器人可以利用本地或云端计算平台来获取使用者当前的情绪,而这与我们寻常使用的语音命令识别又是另一套完全不同的识别体系。

摄像头带来的面部识别则通过人的表情来完成情感计算的过程,这些表情不仅包含了大喜大悲这类的明显面部特征,还会根据一些微表情来完成辅助判断。一般的面部识别只会获取一些关键的参数,且往往用于解锁等安全功能。

智能穿戴,情感计算的另一个入口

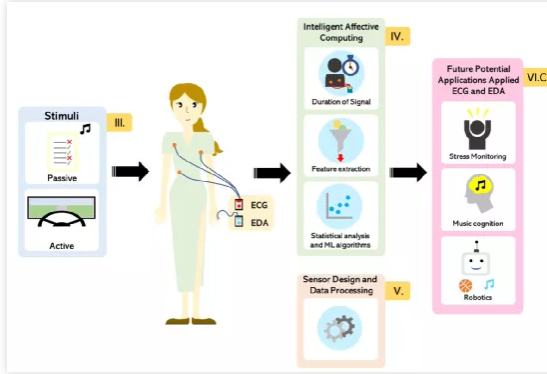

除了机器人以外,情感计算也在慢慢进入另一大市场,那就是智能穿戴。除了以机器视觉、语音识别为主的情感计算以外,另一种获取人类情绪的方式就是通过ECG、EDA、EEG和HRV等生物信号,通过测量这些信号的持续时间,进行特征提取,再通过统计分析和机器学习算法,最终得出使用者当前的情感状态。而当下最方便收集这些数据的自然非智能穿戴设备莫属了。

基于ECG和EDA信号的情感计算/Brainlab

从去年开始,一众智能手表都添加了ECG心电检测功能,Fitbit Sense更是集成了EDA皮电传感器。当然了目前在情感计算尚不成熟的情况下,针对这些功能开发的应用主要以健身为主。但无可厚非的是,智能穿戴设备上的传感器很可能成为未来情感计算中一个关键的入口,而IoT互联技术将作为它的扩散网络。

比如智能穿戴设备识别出忧郁的情绪后,随机播放音乐的关联应用会自动在智能音箱等设备中播放振奋的音乐,或是智能灯具自动将光色调节至正面色彩。不过ECG和EDA这类生物信号目前主要在激动、疲惫和压力等情感判断上更为准确,而在喜怒哀乐等具体情绪识别还是落后于面部识别,所以当前还是更适合用于医疗类的智能穿戴设备,作为一项辅助监测功能。

小结

其实情感计算的产品应用形态远不止于此,目前已经有不少AI虚拟助手融合了简单的情感计算,这些虚拟机器人往往利用的是文本或语音的语义分析来判断情感,从而完成一些电子客服之类的工作。

从这些潜在的情感计算应用来看,情感计算似乎大多都离不开与感知紧密相关的传感器,但目前也有一些研究在探索非侵入式传感器的情感计算。这类情感计算通过现有的一些设备来判断人的情绪,比如人移动鼠标的速度、敲击键盘的频率等,但这类研究的成熟度更低,与以上传感器方案相比,准确度均要低上不少。

总的来说情感计算目前进展还在初期,要想真正感知到人的情感还需要更多的数据输入,也需要厂商进行一系列定制化的传感器设计。