本文来自微信公众号“ISACA”,作者/BELINDA MUELLER。

人工智能(AI)发展如火如荼,特别是随着OpenAI聊天机器人ChatGPT的发布,人工智能更加容易使用,正悄然改变人们的工作、沟通和决策方式。然而,尽管人工智能现在已经成为日常生活的一部分,但人们对人工智能的认知各不相同,有人将其视为一组花哨但无害的算法,也有人将其认为是人类的终结。此外,对于人工智能是否比人类或传统的基于规则的软件具有更多或更少的预期特性(如公平性、准确性和强健性)存在非常不同的意见。

显而易见的是,人们对于如何应对人工智能的发展的态度仍不清晰。对ChatGPT的输出应该给予多少信任?组织能否依靠人工智能做出招聘决策?人们应该如何看待决定他们的信用额度的人工智能工具?人工智能的使用缺乏明确性,这促使监管机构开始建议建立法律框架。特别是,旨在规范人工智能在欧盟的道德和安全部署的《欧盟人工智能法案》(EU AI Act),可能很快就会实施。2022年12月,欧洲理事会就《欧盟人工智能法案》提案的谈判达成共识。

除风险外,许多已部署的IT系统还有其他的关切,例如缺乏安全和数据保护,还有人工智能系统特有的特定风险(即基于机器学习的人工智能)。目前,还没有现成的技术来评估和缓解这种风险。因此,了解人工智能与传统基于规则的系统的区别以及如何解决这些差异至关重要。当将基于规则的系统与人工智能进行比较时,人工智能系统有三个特征特别相关:可解释性、公平性和稳健性。

可解释性

如果人工智能系统的输出及其背后的推理能够被人类理解和信任,那么它是可以解释的。如果无法解释人工智能系统的输出,使得很难控制其正确性和导致统计偏差缺失。其中可以基于预定义规则理解和解释基于规则的算法,许多人工智能模型被认为是所谓的黑匣子。事实上,一些更复杂模型的内部工作原理甚至对其开发人员来说都很难理解。随着人工智能的广泛使用越来越普遍,以及用于医疗诊断或招聘决策等关键目的,可解释性将变得不可或缺。为了满足可解释性的要求,一种选择是使用非常简单、易于解释的人工智能模型。然而,对于许多用例来说,这样简单的模型是不够的。对于更复杂的模型,研究人员和从业者正在开发与模型无关的方法和模型特定的方法。特别是,IBM、微软和谷歌等大型科技企业为所谓的可解释人工智能(XAI)提供了工具:AI Explainability 360和InterpretML。

公平性

最近,人们对人工智能系统的歧视感到不满,例如,奥地利的一家职业介绍所。人工智能系统的公平意味着确保其中立性,防止基于种族、性别和年龄等受保护属性的歧视。由于人工智能是基于真实世界数据训练的,反映了从这些数据中学习到的偏见(例如,社会、历史偏见)。从这个意义上说,人工智能不能被指责为比生成其训练数据的社会更具偏见。基于规则的系统也不一定没有偏见,因为它的开发人员可能会无意识地将他们的偏见融入到系统中。然而,由于人工智能系统可以大规模运行(例如,ChatGPT)并影响大量人群,它们可以系统地延续和放大偏见和歧视模式。为了减轻人工智能模型中的不公平,研究人员和从业者正在努力通过公平指标来识别偏见,并通过偏见校正算法来减轻偏见。然而,选择正确的公平指标绝非易事,因为对公平的解释是主观且因人而异的。事实上,在将对公平的共同理解转化为技术要求之前,人工智能的公平考虑涉及实质性的伦理思考。因此,人工智能模型的公平性不仅是一个技术问题,在很大程度上也是一个伦理问题,需要相关的专业知识。

稳健性

人工智能模型的稳健性是指其能够承受新环境和不可预见输入的挑战的能力。例如,如果人工智能模型从训练数据中过度学习(过拟合),或者训练的数据与部署时的测试数据在统计上不同(数据分布偏移),则人工智能模型可能缺乏稳健性。人工智能系统还面临着恶意行为者利用模型特定漏洞的风险,他们将损坏或误导性数据引入训练数据集(数据中毒)或用扰动数据欺骗系统(对抗性攻击)。例如,图像识别系统可能会将苹果的图像归类为“苹果”,但如果攻击者在苹果上贴上“iPod”的贴纸,它可能会将图像归类为iPod。所谓的捷径学习也会降低强健性,即人工智能模型无法掌握数据中的基本概念,只学习表面特征。因此,例如,图像分类模型可能在大多数情况下对对象进行正确分类,但如果以不常见的方式(例如倒置)呈现就不起作用了。与基于规则的系统相比,验证人工智能模型更加困难。增强人工智能模型的稳健性可以通过在不同场景中进行彻底测试后,对模型性能漂移进行监控来实现。此外,首先对具有代表的数据上训练模型有助于使其更加稳健。

风险评估

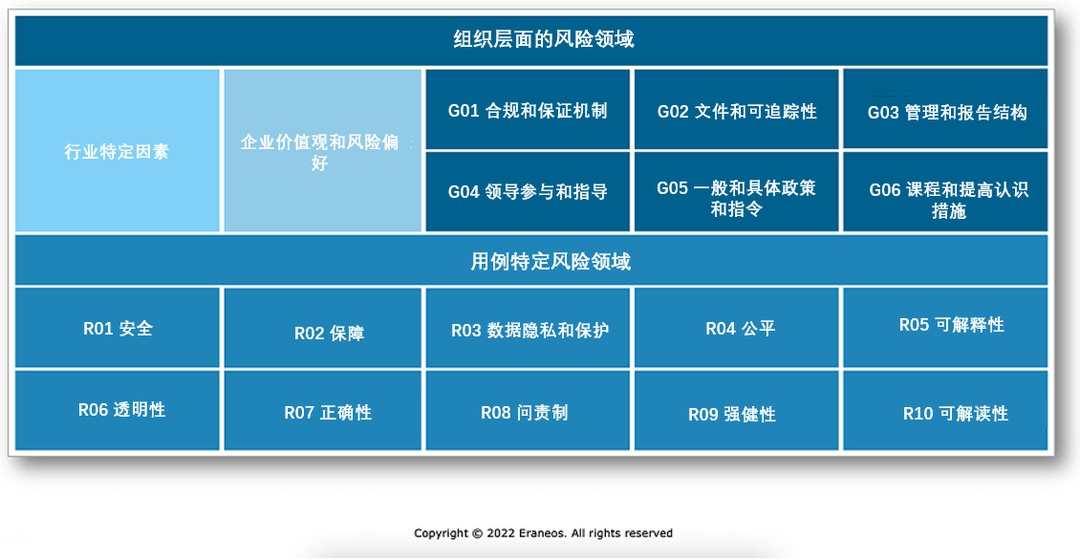

可解释性、公平性和稳健性只是人工智能系统所需的一系列特征的选择。为了全面评估人工智能特定的风险状况,还需要解决更多问题。为了避免盲点,可以应用Eraneos AuditingAI框架(图1)等框架。该框架基于审计人工智能用例和研究人工智能失败的经验。它区分了使用人工智能系统的组织视角和特定用例视角。基于框架定义的风险评估和风险缓释措施问题,可以评估系统整个生命周期中的治理和人工智能特定风险领域。

图1-Eraneos AuditingAI框架

与经典的IT框架相比,Eraneos AuditingAI框架是为人工智能量身定制的,并且具有探索性。对于许多已定义的特征,如可解释性和稳健性,没有既定的控制。新的人工智能模型可能会出现新的要求,在这种情况下,必须对框架进行调整。例如,关于ChatGPT的真实性,目前仍有争论。尽管该框架可以应用于任何人工智能模型,但重要的是要考虑到,根据模型的类型不同,一些用例的特定风险领域比其他领域更相关。例如,线性回归模型的可解释性可以很容易地解决,但对于基于深度学习模型(即非常复杂的模型)的语音识别系统,则更难解决。在这方面,在进行审计之前,进行风险评估并确定任何人工智能系统的相关风险领域至关重要。

结论

随着人工智能模型变得更加复杂,并在各个行业得到更广泛的采用,风险缓解策略需要不断调整。目前,重要的是要记住:

人工智能正在变革日常生活、工作和法规的制定,现在是时候为风险评估和缓解做准备了。

人工智能的风险状况不同于传统的基于规则的软件。特别是,在人工智能系统中,可解释性、公平性和稳健性是必要的。

为了避免风险评估中的盲点,可以使用探索性框架。