本文来自微信公众号“twt企业IT社区(ID:talkwithtrend)”。

前言

随着信息技术的发展,数据已经成为企业的战略资源,如何存储数据以及如何利用数据也已成为企业科技部门研究的热点话题,尤其是伴随着近些年的互联网革命,数据存储世界也发生了翻天覆地的变化,出现了很多新的名词、新的产品、新的趋势等等。面对这些眼花缭乱的事物,如何抽丝剥茧抓住事物的本质其实是从事技术研究工作的首要任务。而对于分布式存储技术这个领域,我认为需要从纵向的存储技术发展脉络和横向的主流技术对比两个方面来深刻认识。

一、存储技术的原始阶段

如果以具备独立存储设备为界限,我们暂且追溯到DAS存储的发展阶段,主要是90年代之前的周期。这个阶段的应用系统主要是单机业务系统,相互之间独立,所需存储的数据量也非常少。但是这个时候数据的安全性已经提升到一定高度,于是基于数据的安全性考虑,将业务数据独立,产生了DAS存储架构。

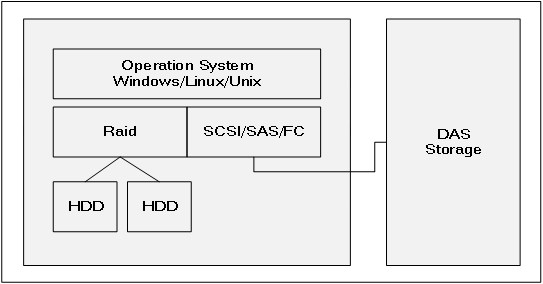

图1.1 DAS存储架构图

DAS(Direct-Attached Storage)

1.通过FC、SCSI、SAS等协议与主机相连接,提供存储服务;

2.DAS存储作为单独的存储平台,可以配置RAID冗余策略来保护数据;

DAS存储架构与之前没有独立存储平台的服务器IT架构相比较,解决了什么样的问题?

任何优势都是相对于特定的历史时期而言的,存储架构的优势也是站在特定的历史时期下来说的。在那个特定的历史时期下,它实现了服务器系统数据和业务数据的分离,相比较之前的服务器内部存储架构来讲,从数据的安全性、灵活性、扩展性方面都有了本质的提高。

1.安全性方面实现了系统数据和业务数据的隔离;

2.灵活性方面去掉了与服务器系统本身的耦合性;

3.扩展性上实现了从若干块服务器机械硬盘的容量到一组甚至几组硬盘的容量规模。

DAS存储架构在自己的时代又经历了哪些进化?

在这个特定的时代,无论DAS存储架构如何进化,都只是量的变化,并没有发生质的改变。例如连接协议的改变,由最初的一条SCSI线逐渐进化为可以冗余的FC光纤线,结合上多路径聚合技术的应用,实现了物理链路的高可用;例如DAS存储产品本身的最大容量由最初的单存储柜容量变成了多柜容量;例如如DAS存储的冗余策略也从简单的RAID1、RAID1+0变为了更丰富的冗余策略;例如数据分布策略逐渐优化到更小粒度的平均分布策略。

二、SAN&NAS共存的发展阶段

伴随着1995年博科(Brocade)公司的诞生,存储区域网络(SAN)的概念走进存储世界,1999年EMC发布第一款支持SAN存储区域网络的存储产品。从此之后,SAN存储便成为企业存储的主导。

80年代,Novell提出了Netware操作系统和NCP(网络核心协议);Sun推出了针对Unix系统的网络文件系统(NFS)协议。1993年,NetApp推出了一个NAS设备。1996年,NetApp又推出了能够同时具备支持CIFS&NFS协议的存储设备,也就是企业级的网络附加存储(NAS)存储设备。

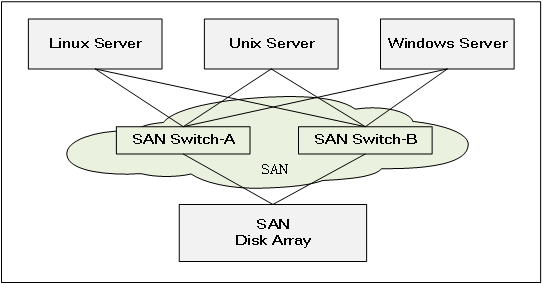

图2.1 SAN存储架构图

SAN(Storage Aread Network)Storage

通过FC协议与主机的HBA卡相连接,提供数据存储服务;

可以提供Block存储载体;

可以实现多链路高性能及高可用读写的数据存储服务;

可以实现远距离的数据存储服务;

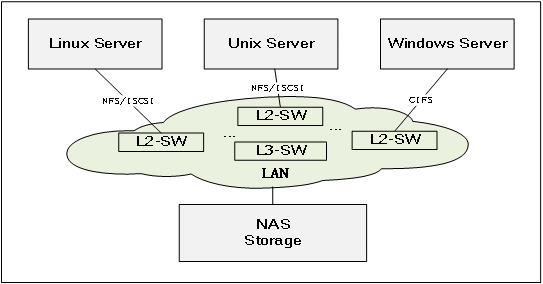

图2.2 NAS存储架构图

NAS(Network-Attached Storage)

通过以太网络协议与主机相连接,提供数据存储服务;

只能提供文件系统作为数据存储服务的载体;

可以实现文件系统级别的数据共享服务;

可以实现远超远距离的数据存储服务。

为什么NAS和SAN存储逐渐取代了DAS存储?

随着信息化的不断发展,应用系统逐渐由单机式的业务模式发展为CS/BS的前后台组合模式,业务系统之间的耦合性越来越强;数据的重要性逐渐凸显,对企业存储的安全性和稳定性有更高要求;数据量的增长不再是定格在某个业务系统的模式,更多的是系统群的数据增长模式,而这种变化对企业存储的灵活性、扩展性以及容量本身都提出了更高的要求。在这些变化的驱动下,NAS和SAN存储必然取代DAS。

SAN存储与服务器实现了物理连接的解耦;

SAN存储可以在应用服务器之间实现存储设备的共享;

SAN存储与服务器之间的链路实现了高度冗余,在性能和高可用都得到质变;

NAS存储可以支持更灵活的以太网协议;

NAS存储可以实现文件系统级别的数据共享;

NAS存储可以实现超远距离的数据存储服务。

为什么SAN存储虽然是企业存储主流,但也始终无法取代NAS?

或许我们可以举出很多很多二者之间的区别,从连接协议、数据载体、灵活度等等各个方面都会有一些差异导致不同场景下的优劣。但是我认为最根本原因还是在于性能问题。NAS存储的性能瓶颈在于其传输协议和数据载体类型。20世纪前后,以太网的发展多数停留在千兆级别,与同时代SAN网络的4GB、8GB FC相比,速度相差太悬殊了。文件系统虽然可以直接存放文件,但是其读写的控制机制相比较Block模式来讲要复杂很多,性能开销大打折扣。也许有人会说因为SAN存储大部分应用于数据库类的应用,而数据库类的应用不适合文件系统。表面上这句话没错,但是谁说数据库的容器(DB2)或者数据文件(Oracle)就不能是文件系统上的文件呢,而非得Block存储卷呢?其根本原因还是在于底层的读写性能。

那么反过来,为什么NAS还能一直存在并与SAN存储并存呢?

这个还是取决于它支持的协议和文件的载体,有一些数据存储场景更适合于以太网协议,并且更适合文件系统作为载体。SAN网络要想传输到相对远距离的区域,比如不同楼宇、不同园区、不同地区,从成本上、技术上、灵活性上来看都会力不从心。Block存储要想实现数据的共享读写,不是不可以,但是必须得依赖于应用的共享控制机制,比如HA软件和LVM,而NAS存储天生支持NFS和CIFS共享协议。

SAN&NAS存储架构在自己的时代又经历了哪些进化?

在属于自己的时代里,SAN和NAS存储架构围绕着扩展性、高可用、性能以及TCO等因素各自伴随着新的软硬件技术诞生发展而衍生出新的发展趋势。

1).存储控制器的扩展性发展趋势。

最初的SAN存储基本属于双控制架构,两个控制器的工作模式由最初的AS模式发展为AA模式,为整个存储系统提供数据的读写控制服务,后续逐渐发展为网状架构多控的负载均衡集群模式。

2010年HP公司完成对3PAR公司的收购,标志着HP存储系统从原来的双控四控EVA存储架构转化为网状架构的8控、16控高端SAN存储架构。2011年,EMC公司将其Symmetrix VMAX产品定位为主推产品,意味着其SAN存储产品由原来的双控VNX产品系列转化为网状多控集群架构。

这个变化导致了SAN存储在吞吐量、性能、高可用、容量等方面都得到了质的飞跃。

2).虚拟存储卷的池化技术越来越精湛,映射单元粒度变小、数据分散度提高。

最初基于双控模式的SAN存储的虚拟存储卷一般是基于物理磁盘组基础之上做一次分配和映射形成虚拟卷,后续的SAN存储虚拟卷逐渐发展为多层映射并且最小的物理存储单元粒度越来越小。

以EMC的VMAX为例,其存储卷Virtual Volume到Physical Disk之间除了有DiskGroup的概念,还有Physical Device、Virtual Device、Storage Pool、Thin Pool等多个对象,正是这些对象的多层映射使得提供存储服务的虚拟存储卷所对应的实际物理存储空间映射到了成百上千块物理磁盘的小粒度存储单元空间上。

这种技术的改变一方面逐渐消除热点数据集中在局部物理存储空间的可能性,提高了数据读写的整体性能。另外一方面,数据在物理存储磁盘上的分散程度提高,可能面临的物理磁盘故障对数据安全性影响变小,提高故障数据的恢复速度以及降低数据恢复过程对存储系统的性能影响。

3).存储管理软件功能越来越完善,越来越强大。

随着高端SAN存储的不断发展,尤其是2015年之后的发展阶段,高端SAN存储上逐渐增加了数据空间利用率管理、数据保护管理、数据性能管理等方面的各种软件功能。

数据消重功能:其功能就是在存储端将上层应用存储的重复数据保留一份,从而提高物理空间的利用率。其本质上是以BLOCK为单位进行数据对比,仅在物理存储空间保存一份,而在虚拟存储卷到物理空间的映射上增加指针的软件技术。

数据压缩功能:其功能就是在存储端将读写访问频度较低的数据,基于压缩算法进行数据压缩,提高物理空间的利用率。具体压缩算法有很多,压缩类型也包括有损和无损两种。但是无论是什么算法什么类型,其对CPU的消耗是必然的,如果刚刚压缩的数据又被访问到的概率越高,解压的代价就越高。

克隆技术和快照技术:存储卷的克隆技术是指在存储设备上,基于存储卷的Block存储单元而进行完全复制形成的完全相同的存储卷,用来做数据备份恢复。快照技术是指基于某个存储卷的Block存储单元而进行指针映射而形成一个虚拟的存储卷,同样用来进行数据备份恢复。需要注意的是克隆出来的卷虽然数据完全一样,但是存储卷的元数据信息是不一样的,采用存储卷直接替换方式进行系统恢复的时候需要考虑应用对存储卷元数据的识别。快照技术是一种修改即拷贝的机制,使用时需要注意数据修改对存储空间使用的影响。

瘦存储卷技术:瘦存储卷技术也就是存储设备是否支持使用Thin模式。分配卷时并不分配真实容量的物理空间,而是在存储卷需要存储数据的时候才会逐渐分配物理空间。同样也是基于企业TCO的考虑。将应用在一段时间内可能需要的存储规模划定好,但是真实的物理存储空间是逐年扩容投入并且是按需投入。但是需要考虑使用溢出的风险。

数据分层技术:通俗理解数据分层技术就是把正确性能要求的数据放在正确性能的存储载体上。存储磁盘有快有慢,成本与性能成正比,为了平衡TCO与性能要求的不可预见性,通过软件算法自动将不同性能要求的数据放在不同读写速度的物理磁盘上。

4).随着存储虚拟化技术的发展,其逐渐成为企业容灾框架的关键技术。

SNIA(Storage Networking Industry Association)存储网络工业协会对存储虚拟化是这样定义的:通过将一个或多个目标(Target)服务或功能与其它附加的功能集成,统一提供有用的全面功能服务。通俗讲,虚拟存储技术将底层存储设备进行抽象化统一管理,向服务器层屏蔽存储设备硬件的特殊性,而只保留其统一的逻辑特性,从而实现了存储系统集中、统一而又方便的管理。对比一个计算机系统来说,整个存储系统中的虚拟存储部分就像计算机系统中的操作系统,对下层管理着各种特殊而具体的设备,而对上层则提供相对统一的运行环境和资源使用方式。

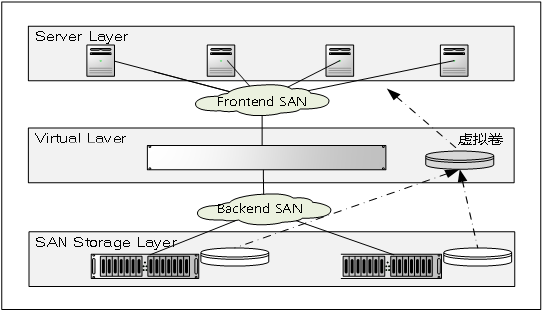

图2.3存储虚拟化架构图

SAN Storage Virtual Gateway Layer

通过SAN网络的ZONE隔离策略将SAN网络在逻辑上隔离为前后端网络,前端包括服务器和存储虚拟化网关设备,后端包括存储虚拟化网关设备和SAN存储设备;

存储虚拟化网关层代替SAN存储向服务器提供存储卷服务;

存储虚拟化层提供给服务器的存储卷是经过了整合或者镜像之后的虚拟化卷。

从SAN存储的虚拟化技术发展历史来看,其实最初的虚拟化技术主要的是实现存储卷的集成功能,更多的是企业存储立旧的目的。例如IBM的V系列存储最初的存储卷虚拟化功能就是要实现对IBM系列老旧存储的集成。V系列存储的虚拟存储卷可以由多个物理存储设备上的物理卷组成。但是随着IBM SVC产品以及EMC VPlex等产品的出现,存储虚拟化技术主要用来做1:1镜像存储卷实现数据在不同区域的高可用保护或者是容灾保护。

另外一方面,存储控制器的虚拟化发展模式更加促进了容灾技术的逐步完善。近些年来随着计算虚拟化的不断发展,操作系统虚拟化及容器的概念不仅仅改变了服务器的使用习惯,而且部分引入到了存储操作系统的管理当中,存储控制器由物理节点为虚拟节点,可以对控制器的网络、存储卷、缓存、CPU等资源动态重组并实现在物理硬件上的平滑迁移,最终提高容灾系统的RPO。例如Netapp的FAS产品系列的Data Ontap。

5).存储架构逐渐走向整合模式。

存储架构逐渐走向统一整合的模式主要体现在3个方面:

NAS存储功能和SAN存储功能逐渐走向整合。同时兼备NAS功能和SAN存储功能的产品逐渐增多,Netapp由最开始的NAS专注者转变为统一存储提供者,从FAS8000系列开始,其产品兼备NAS、SAN以及存储虚拟化容灾功能。EMC VMAX 10K还仅仅是一个独立的SAN存储,从VMAX 20K开始已经转变为兼具NAS功能的统一化存储产品。

高性能小容量磁盘介质与低性能大容量磁盘介质走向整合。SAN存储发展到2015年前后,细数各家存储设备厂商的高端存储设备,基本上分层管理技术(FAST)已经成为其必备功能。分层技术已经发展到可以针对分层的时间窗口以及分层的性能指标等多个维度进行自定义。企业也越来越多的开始使用这种技术来平衡企业存储投入TCO。

存储运维管理走向统一化。在存储虚拟化技术的基础之上,越来越多高端存储产品具备对不同类型甚至不同品牌的存储产品进行管理上的整合。以EMC的VPlex为例,其不仅仅可以兼容EMC自己的存储产品系列,而且可以兼容很多其他品牌的存储产品,然后在其之上形成一层虚拟化存储抽象层,从而实现存储管理工作的统一化和便捷化。

三、软件定义存储的兴起和存储架构的百花齐放年代

伴随着2010年之后的互联网迅速发展,企业的应用发生了很大的变化。

应用访问模式上,伴随着Web1.0、2.0、3.0的飞速发展,越来越多的业务模式转变为BS模式,业务访问的并发量上发生了有史以来最大量级的升级。业务特性上,分析类业务剧增,依靠数据分析挖掘商机的时代到来。大数据、BI等新型业务系统纷纷在企业信息系统群中上线,数据本身的再生产价值能力受到空前的重视。业务跨度上,伴随着云计算的发展,越来越多的业务成为互联网业务,不仅仅需要从云端获取必须的数据,而且需要从云端获取海量数据生产加工之后的价值数据。企业数据上,越来越多的非结构化、半结构化数据形态涌入企业应用系统;数据量级呈爆发式的增长;数据生命周期管理由原来的在线离线为主的模式转变为多生命周期的模式;数据分析成为企业必备的核心后台。

在这些变化的驱动下,传统SAN存储架构已无法满足某些企业数据存储的灵活性、扩展性、并发性等方面的需求,于是一些互联网企业率先开启软件定义的应用之路。从2014到2019的五年时间内,软件定义存储的市场将从14亿美元增长到62亿美元以上,年复合增长率高达35%。而2017年也被誉为是软件定义技术的元年。Apache Cassandra、CouchDB、MongoDB、Redis等一系列NoSQL数据库软件解决方案逐步走进互联网企业并且成熟,Ceph、Swift、GlusterFS等对象及文件系统类软件存储解决方案也逐步走进企业的IT试验田。

说了这么多,究竟什么是软件定义存储(SDS,Software Defined Storage)?

软件定义简单来说就是指资源由软件自动控制,通过抽象、池化和自动化等一系列处理后,将标准服务器内置存储、直连存储,外置存储,或者云存储等等的存储资源整合起来,实现应用感知或者基于策略驱动的部署、变更和管理,最终达到存储即服务的目标。

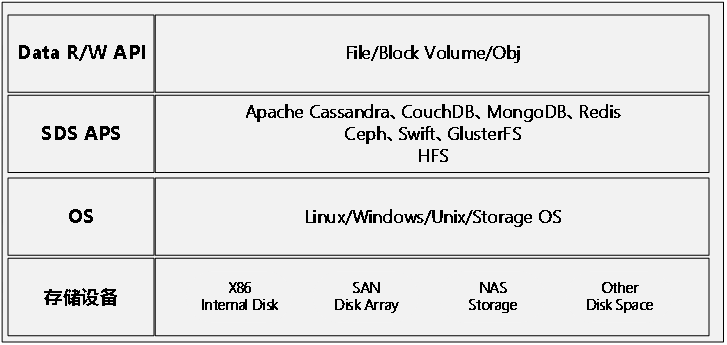

图1.1 SDS存储框架图

SDS(Software Defined Storage)

从图中的框架来看,首先需要明确的是SDS并不是某一款具体的存储产品,而是一个技术框架,一种技术理念。从下往上,共有四个层次:存储设备层是最底层的数据存储物理载体,在这种框架下,对物理存储载体的要求空前放宽,任何性能、任何形态、任何容量、任何连接都可以接受。只要他们具备一个条件即可,那就是可以被上层操作系统识别为可用存储介质,可以定义为上层操作系统的可用设备。操作系统层承载着两方面的作用,一方面需要识别到底层可用的存储设备,另外一方面要提供软件运行的环境。SDS APS也就是存储软件层,无论是什么样的存储软件,它只是作为操作系统环境运行的一个软件,其特殊之处在于它可以将系统识别到的存储设备进行整合并以应用可以操作的接口提供给应用。最上层的Data RW API,也就是数据的读写接口,它可以按照应用可以读写的数据库语言接口方式、数据文件方式或者是普通的文件系统、对象接口、Block存储接口等方式提供给应用程序所用。

为什么软件定义存储会在2014年之后逐渐兴盛?

首先,任何事务都不是孤立产生的,SDS同样是这样的。当现有环境下的事物无法满足特定需求时,人类必然会探求新的解决方案。当传统SAN存储无法解决互联网带来的特殊数据形态存储需求,无法解决数据量暴涨带来的存储TCO困惑,无法解决突如其来的并发量带来的访问性能瓶颈的时候,一些互联网企业开始将一些尘封在实验室或者大学研究室当中的思路探索性的应用到了自己的新环境。例如,谷歌在2003、2004、2006年仅以学术共享形式发表的Google FS、MapReduce、BigTable三篇论文,十年之后却成为互联网企业实际应用的先驱模板。而且随着企业业务模式的不断发展,这些源代码经历了多次有针对性的优化和改造,解决了很多新的场景问题。

在SDS兴起的时代,存储架构技术有了哪些新的变化和发展?

1.新型数据库类(NOSQL)的数据存储解决方案不断涌现

互联网业务高度并发的场景下,Redis、Memcache在逐渐成为主流的键值型缓存解决方案;面对互联网的海量HTML网页型的数据场景,Hbase等系列列式数据库成为主流解决方案;面对实体关系类的社交数据场景,Nego4j系列图形数据库逐渐走进一些以社交业务为主的互联网企业;MogoDB系列文档数据库逐渐替代以NAS及内容管理软件组合起来的影像类解决方案。

总而言之,新数据类型的出现激发了很多基于新型数据类型以及新的数据存取及访问特点而产生的新数据存储需求,而这些新的数据存储需求又促生了这些新的NOSQL数据库解决方案。

2.超融合架构技术在制造行业应用的不断扩展

以提供存储产品的厂家不可能坐视自己的市场份额逐渐减少,于是在百花齐放的年代他们开始认真审视自己的产品和时代的特点,针对于IT自控能力不足,但是又希望能够适应时代特点,分享新技术带来收益的一部分企业群体,提出了超融合架构解决方案。以起初的EMC VxRail、Nutanix、Cisco HyperFlex等为代表发展到华为、华三、联想、深信服、SmartX等百花齐放的阶段,场面可谓壮观。

众多的超融合解决方案在存储层面,基于vSan、HDFS、HXDP、Ceph等软件定义存储原型进行优化改造并封装成通用商业产品融入超融合架构。

3.对象存储的应用由媒体视频行业扩展到制造、交通、政府以及金融等各个行业

虽然互联网应用对性能和容量的要求极高,但是对其它特性却没什么特别的要求。甚至可以说它对其它特性基本上没有太多要求。由于其存储的主要是图片,而且对图片的存储是一次存储,多次访问,没有修改。在这种需求的驱动下,对象存储解决方案应运而生。2004-2009年间,出现了真正的对象存储先锋。主要的厂商为Caringo,Cleversafe,Amplidata,Compuverde,DDN(Bucket File System)等。Ceph是2014年通过Inktank以1.75亿美元收购,而Gluster则早在2011年就被红帽以1.36亿美元收购。对象存储应用领域也从最初的互联网行业的图片、视频存储覆盖到了各行各业的非结构化数据存储领域。

4.SAN存储从通用企业级存储解决方案逐渐走向高性能结构化数据存储解决方案场景

在这个特殊的时代,随着数据存储的各种新需求出现,存储架构也呈现百花齐放的状态。独霸江湖数十年的SAN存储终于有了更聚焦的定位。尽管很多数据存储场景找到了更适合的软件定义存储产品或是对象存储产品,但是以结构化数据为存储对象的传统应用场景似乎还是非SAN存储莫属。由于结构化数据结构与Block存储的天然契合性、结构化数据读取性能的要求以及结构化数据对并发控制的严格要求导致SAN存储依然独树一帜。于是越来越多的企业将SAN存储的定位更明确化清晰化。

四、存储架构技术沉淀并分类聚焦的时代

近些年来,伴随着一些历史事件的发生,存储架构技术的发展伴随着百花争鸣的喧嚣逐渐走向了安静。该淘汰的淘汰,该沉淀的沉淀,最终呈现出清晰的发展脉络。首先我们来看一些有意义的历史事件:

2010年:EMC收购Isilon;

2012年:VMware提出SDDC(软件定义数据中心)和SDS(软件定义存储)的概念,之后推出SDS产品–Virtual SAN的预览版;

2013年:Avago收购LSI;

2014年:闪迪收购Fusion-io;

2015年:XSKY成立;

2016年:IBM收购对象存储;HCI(超融合)概念提出者Nutanix上市;

2017年:HPE收购Nimble Storage;

2018年:微软收购混合云数据存储公司Avere Systems;

2019年:AWS收购E8 Storage;谷歌收购存储企业Elastifile;IBM收购RedHat Ceph和Gluster。

存储世界发生的这些大事件推动着企业的存储架构技术变革也呈现出一系列清晰的脉络:

1.分布式成为企业存储架构追求的主要目标之一

根据Gartner对于2020年全球外置存储市场统计来看,分布式存储发货容量13ZB、销售额33亿$。2018年到2023年期间,中国分布式存储市场年均复合增长率将达到22.4%。不难看出,在数据量不断暴涨和国产化趋势的双重驱动下,分布式存储逐渐成为企业追求的目标之一。

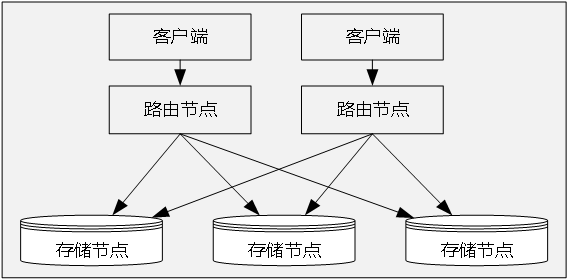

图2.1 DSS存储框架图

从架构设计角度看,大规模数据量的场景下是分布式架构最擅长的地方。传统存储阵列采用Scale-up架构,评价其架构设计好坏的标准是在有限的处理器、内存资源下提供更高的可靠性和性能,管理更大的存储容量。分布式存储采用Scale-out架构,以处理器、内存、硬盘构成一个个独立的扩展单元,客户端经由路由节点直接从各个独立扩展单元获取所需要的数据片段,其架构设计追求的目标是更大的扩展能力。从企业TCO角度看,虽然存储厂商暂时陷入比拼硬件成本的恶性竞争状态,专业的软件价值暂未得到应有认可。但是越是海量数据的场景,分布式存储的成本优势越突出。

2.SAN存储领域陆续将全闪存储作为主流SAN存储产品推出

全闪存储指全部由固态存储介质构成的独立存储阵列或设备。全闪存储的高速发展,既是新应用对性能需求驱动的结果,也是闪存技术不断创新的成果。近些年来,各大存储厂商均推出了全闪存储产品,相较传统机械存储,在存储性能委员会(SPC)的SPC-1基准下,业务性能提升了5倍;在数据库场景下,业务性能提升了10倍;在虚拟桌面场景下,启动响应时间缩短80%。

技术上与传统的机械硬盘相比较,时延从2ms降低到0.02ms,5年返还率从13.4%降低到0.8%,功率从10W降低到3W。这三大指标决定着全闪存储从性能、稳定性、节能三方面都得到了质的提升。TCO投入上与传统的SAN存储相比,二者之间的差距逐渐缩小。综合评估性价比的话,从实际印证的结果来看,企业越来越偏向于全闪存储,尤其是在关系数据库的关键应用上。

3.存储平台的数据分析支持能力逐渐被提到相当高度

存储平台的数据分析和挖掘能力来源于电商业务的驱动,最初的电商行业主要依靠海量用户数据的分析来挖掘其潜在的商业价值。近些年来数据的价值分析已经嵌入到各行各业,金融行业用这些海量的数据来分析反洗钱、信贷管理、监管报送等业务,保险行业用其客户画像数据和海量的关联数据分析来计算客户的保险系数,制造行业用其海量的过程数据来提高产品的良率,安保行业用海量的视频数据来智能比对、精准追踪、打击犯罪,交通行业用海量的交通数据做智能交通调度等。

总而言之,数据存储平台不再是一个孤立的载体,而是向开放的、智能的、可再利用的中间平台过渡,很多企业开始打造整合多种功能于一体的的数据中台和后台。

4.云存储架构逐渐融入企业IT架构当中

面对数据增长带来的挑战,很多企业现有的FTP、NAS、Windows共享等存储共享方式已逐渐满足不了企业数据存储和管理的业务需求。据IDC数据显示,到2025年,全球创建、获取和复制的数据量将增至175ZB,其中,企业存储的数据量将会占据全球总数据量80%以上。这一数据表明企业正迅速成为生产数据和管理数据的主要载体,加上目前我国正处于云计算的高速发展时期,企业上云成为必然趋势。越来越多的企业选择将自己的日常办公数据、备份数据、归档数据、静态历史数据等活动性不强的海量数据移入云存储资源池甚至直接推向云端。

从企业运维管理的角度来讲,伴随着云计算的不断推广发展,企业IT运维管理必然走向自动化,那么存储作为云端必不可少的重要资源,它的使用和管理也必然融入企业云。