本文来自微信公众号“半导体行业观察”。

Jensen Huang声称Nvidia的新型Grace Hopper Superchip将CPU和GPU结合在一个集成模块上,与传统CPU相比,可以降低能源成本,同时为生成式AI工作负载提供更快的性能。他表示,该芯片还可以帮助企业节省大量资本成本,以实现与CPU相同的基准性能。

Nvidia首席执行官黄仁勋有一句口头禅,他在上周的SIGGRAPH 2023主题演讲中说过多次,几乎成了一个笑话:“买的越多,省的越多。”

黄仁勋指的是这家GPU巨头的断言,即与传统CPU相比,其AI芯片可以为公司节省大量成本,因为他认为未来的数据中心是由对生成式AI功能的需求推动的,依赖大型语言模型(LLM)回答用户查询并为各种应用程序生成内容。

“未来的典型用例是几乎所有事物前端的大型语言模型:每个应用程序,每个数据库,每当您与计算机交互时,您可能首先会参与大型语言模型,“他说。

黄说,英伟达的人工智能芯片可以为专注于大型语言模型和其他计算密集型工作负载的数据中心运营商节省资金,因为这些芯片比CPU运行得更快、更高效,而且他们购买的芯片越多,获得的芯片就越多。

“这就是加速计算将成为前进道路的原因。这就是全球数据中心快速过渡到加速计算的原因。”黄仁勋说道。

“有些人说——你们可能听说过,我不知道是谁说的——但是你买的越多,你节省的就越多。这就是智慧。”他补充道,行业爱好者们也跟着笑了起来。

但尽管气氛搞笑,黄对潜在的主张很严肃,强调这些观点应该是他主题演讲的主要内容。

利用人工智能芯片节省能源和资本成本

为了说明Nvidia芯片在数据中心中的优势,黄仁勋举了几个例子,将它们与CPU进行比较,一个重点是它们如何在提高性能的同时降低数据中心的总体功耗预算,另一个重点是芯片如何显着降低资本成本。

黄仁勋的示例基于该公司迄今为止最先进的人工智能芯片Grace Hopper Superchip,该芯片结合了72核Grace CPU和Hopper H100 GPU,通过高带宽芯片间互连以及480GB LPDDR5x内存连接如果明年推出更新版本,则将配备141GB HBM3e高带宽内存。

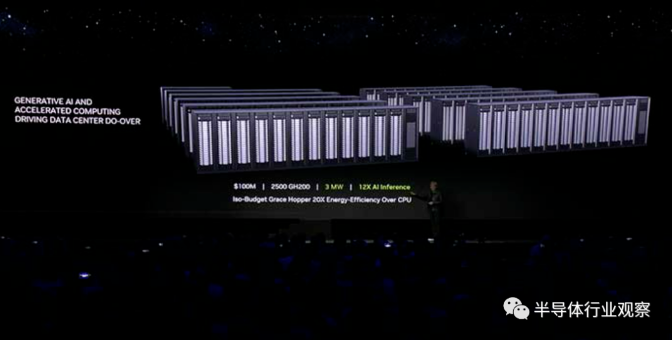

在功率预算示例中,Huang提供了一个预算为1亿美元的假设数据中心,该数据中心正在运行他认为是生成式AI用例的代表性工作负载组:Meta的Llama 2 LLM与矢量数据库和稳定扩散结合使用XL法学硕士。

数据中心运营商可以使用1亿美元购买8,800个英特尔Xeon Platinum 8480+CPU,这是其最新服务器芯片系列中速度最快、核心数量最多的处理器之一,这些处理器将为数据中心提供5兆瓦的功率预算,黄说。

相比之下,1亿美元还可以购买2,500个Grace Hopper Superchips,并将数据中心的电力预算减少到3兆瓦。此外,黄说,数据中心能够在LLM和数据库工作负载上运行推理,速度比仅CPU配置快12倍。

他补充说,这意味着能源效率提高了20倍,而按照摩尔定律,传统芯片制造商需要“很长时间”才能实现这种水平的提高,摩尔定律是英特尔倡导的观察结果,即晶体管数量集成电路每两年就会增加一倍,从而带来性能和效率的提升。

“这是效率和吞吐量的巨大进步,”黄说。

在另一个例子中,黄以同样价值1亿美元的数据中心为例,配备8,800个英特尔至强CPU,并表示如果数据中心运营商想要使用Grace Hopper Superchips实现相同的性能,只需花费800万美元和260千瓦的功率预算。

“因此功耗降低了20倍,成本降低了12倍,”他说。

合作伙伴表示Nvidia的口号是正确的

Nvidia顶级合作伙伴的两位高管告诉CRN,他们的公司已经证明,当客户从基于CPU的数据中心基础设施切换到由GPU驱动的数据中心基础设施时,他们可以在许多情况下提高计算密集型应用程序的性能并节省资金。

总部位于德克萨斯州休斯敦的Mark III Systems首席技术官Andy Lin表示:“过去5到10年,我们一直在让人们从CPU转向使用GPU,这极大地加快了这些工作的速度并降低了成本。”今年被评为Nvidia北美顶级医疗保健合作伙伴。

Lin表示,他对像Grace Hopper这样的芯片能够通过在CPU和GPU之间创建内存一致性以及删除通用x86 CPU中不必要的功能来进一步提高性能和效率感到兴奋。

“当你有专门为这些类型的工作负载构建的东西时,经济效益往往会更好,因为它们是专门为此设计的,而不是在通用x86 CPU中产生大量浪费,因为它们有必须考虑的东西所有可能性,不仅仅是你的深度学习工作,不仅仅是你的机器学习或支持加速器的软件,”他说。

总部位于马萨诸塞州普利茅斯的Microway负责高性能计算和人工智能营销和客户参与的副总裁Brett Newman表示,他的大多数客户在将工作负载从计算机中转移出来时,经常会利用在资本成本和能源方面节省的成本。CPU到GPU。

“最常见的结果实际上是混合。他们会说,‘太好了,我将[使用]一些通过加速计算可能节省的资金来[获得]性能的整体提升。但我也会节省电力和能源效率,”他说。

自从英伟达几年前率先推出GPU计算以加速科学计算工作负载以来,纽曼一直看到这一主题。

他补充说,现在许多组织都在开发生成式人工智能应用程序以满足高行业需求,因此更需要从GPU中榨取尽可能多的性能。

“他们对计算有着持续不断的需求,他们会利用任何可以获得的计算能力进步。有时,节省电力预算是件好事,但有时他们会说,‘太好了,然后我想运行下一个计算量更大的应用程序,’纽曼说。

英特尔、AMD推出新型人工智能芯片加剧竞争

黄仁勋在SIGGRAPH主题演讲中没有提到的是,虽然英特尔正在努力推广其用于某些人工智能工作负载的CPU,但更大的竞争对手正在大力推动销售与Nvidia的GPU竞争的强大人工智能芯片。其中包括来自Habana业务和数据中心GPU的Gaudi深度学习处理器,其中最强大的处理器于今年早些时候推出。

纽曼表示,考虑到英伟达“令人难以置信的产品和路线图”,他认为英特尔不会变得更具竞争力,直到这家半导体巨头合并其人工智能芯片路线图并将其Gaudi芯片技术融入未来的GPU中,从Falcon Shores开始。2025年。

“问题在于产品何时上市以及上市后的情况如何,”他说。

当谈到Nvidia的另一个主要竞争对手AMD时,纽曼认为,当AMD今年晚些时候推出Instinct MI300芯片时,竞争对手的芯片设计商可能会“在正确的时间拥有很多正确的东西”。

“现在,感觉每个人都想分一杯羹。而且这块蛋糕做得越来越大,可能足以让每个人都从中拥有真正健康的业务,”他说。