本文来自微信公众号“数据猿”,文/摘星狐狸。

在当代人工智能领域中,如果将算力比作是AI的燃料,那么大模型则相当于AI的发动机。算力充当着AI体系运作的根基,使得复杂的算法和模型得以运行,大模型则将这些算力转换为具体的智能输出。而开源大模型则是人人都能用得上的发动机。

在信息技术的发展历程中,开源社区的作用就像是催化剂,它加速了知识的共享、技术的创新和问题的解决,让一项新技术以最短的时间迭代完善。这种开放协作的精神如今也在推动大模型的发展。作为人工智能领域的前沿技术,大模型的复杂度和研发成本都相对较高,开源社区的存在极大地降低了这些门槛。

本文将梳理国内外开源大模型的发展现状,对比不同开源模型的技术路线,尤其是中国开发者的探索和尝试,找出数据背后隐藏的大模型发展趋势。

开源大模型的演进–从探索到突破

大模型受到广泛关注无疑是从OpenAI的ChatGPT开始的,而其背后的GPT-3.5和GPT-4都是闭源模型。给人的感觉似乎是整个大模型行业就是由闭源模型撬动的,然而事实恰恰相反。

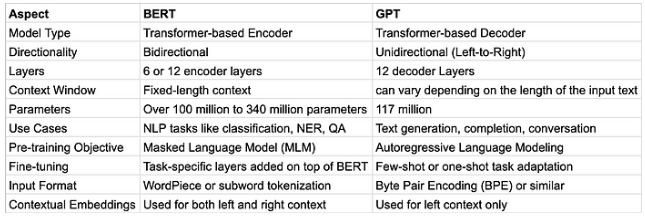

早在2018年,谷歌就开源了基于Transformer架构的BERT模型,打破了语言模型只能顺序读取文本的印象。通过双向输入,BERT可以在两个不同但相关的NLP任务上进行预训练:掩码语言建模(MLM)和下一句预测(NSP)。这使得BERT能够建立上下文来帮助计算机理解文本中的歧义。同时,BERT-large拥有3.4亿参数,使用大量文本进行预训练,并且可以使用问答数据集进行微调。这也奠定了后来“大规模参数+预训练+微调”的模板。

2019年,OpenAI开源了GPT-2。相比BERT,GPT-2的生成能力更强,预训练数据集也更大。而此后的开源模型也逐渐朝着“更多参数,更大数据集,更长上下文”的方向发展。

BERT模型与GPT模型对比图

2022年,OpenAI的GPT-3横空出世,参数量来到了1750亿,而基于人类反馈的强化学习(RLHF)的概念也深入人心。从这时起,OpenAI便一路领跑。但即便如此,OpenAI的CEO山姆·奥特曼(Sam Altman)也承认,OpenAI的最终目标是开放的通用人工智能。

由于大模型的训练成本高昂,很多企业从商业角度考虑,选择闭源自家的大模型。也有一些企业担心开源之后,被滥用的模型会带来安全风险。尽管如此,开源社区依然在蓬勃发展。

2023年,Meta开源LLaMA模型,最大参数量650亿,训练数据量达到2.0 T tokens。

2024年3月,xAI开源Grok模型,最大参数量3140亿,是目前开源模型中参数规模最大的。

与此同时,国内的开源大模型也开始崭露头角,清华大学联合智谱AI开源的GLM系列模型就是其中的代表。

全球视角–开源大模型的玩家们

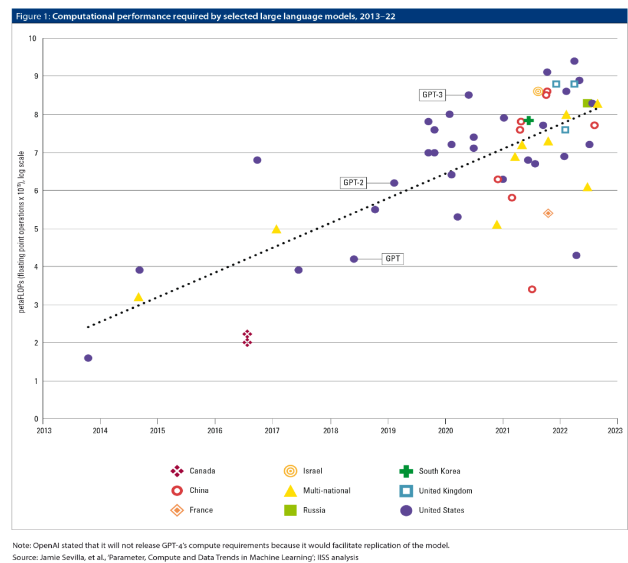

根据IISS发布的报告,目前参与开发大模型的主要国家是中国和美国,此外还有英国、法国、韩国、俄罗斯、以色列,以及众多的跨国企业和研究机构。如下图所示,全球大模型的算力需求快速增长,各国都投入了大量资源建立自己的模型。

全球大语言模型算力需求趋势图

模型的开发者们尝试了多样化的发布方案,包括不发布模型(如谷歌截至2023年3月21日对Bard的限量公开)、对API输出进行限制(例如OpenAI虽然开放了GPT-4的API调用,但是在固定时间内的调用次数非常有限)、在非商业性许可下共享模型(Meta开源了LLaMA,任何人都可以使用,只有在产品的月活用户数超过7亿的情况下才需要Meta的专门许可),以及将模型完整地、可下载地放到网上(类似于EleutherAI和BigScience研究组的做法)。

总的来说,研究机构和跨国公司更倾向于将模型开源。对于前者来说,开源除了能推动创新,也能一定程度上规避重复工作的风险。而对于后者来说,通过开源,公司可以展示其技术实力,增强品牌影响力,吸引潜在的客户和合作伙伴(尤其是研发人才),甚至将开源生态打造成自身的竞争优势。比如阿里巴巴,既开源了QWen大模型,也推出了商用版本,阿里云上也有其他的大模型。

要平衡开源和商业并不容易。对于开源部分要有清晰的许可证和商业使用条款,而对于商业部分,一方面要让用户和开发者了解开源模型和商业模型之间的区别,保持足够的透明度,另一方面也需要有相应策略来确保开源模型的商用不会导致与社区的利益冲突。在行业大发展的背景下,开源利大于弊。

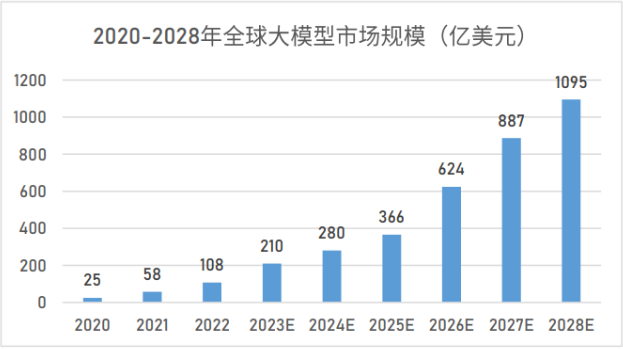

根据大模型之家的测算,2024年,全球大模型市场规模将达到280亿美元,到2028年,其规模将达到1095亿美元。

如此庞大的市场,中国又在其中占有怎样的分量呢?

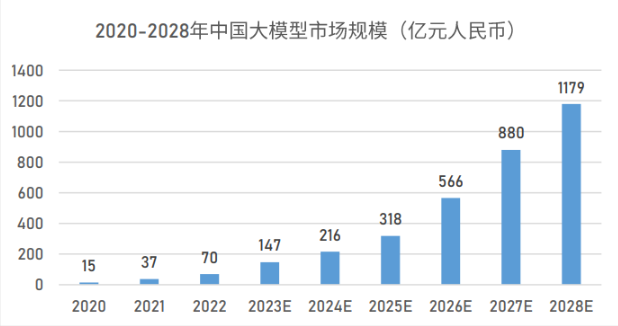

据大数据之家的预测,到2024年,中国大模型产业的规模有望达到216亿人民币,

并预计在2028年将增至1179亿人民币。

这一市场不仅广阔,而且发展迅速,加之国内庞大的工程师队伍,为本土大模型的成长和扩张创造了有利的外部环境。那么当前的竞争格局又呈现出怎样的特点呢?

开源大模型全景–核心玩家和他们的模型

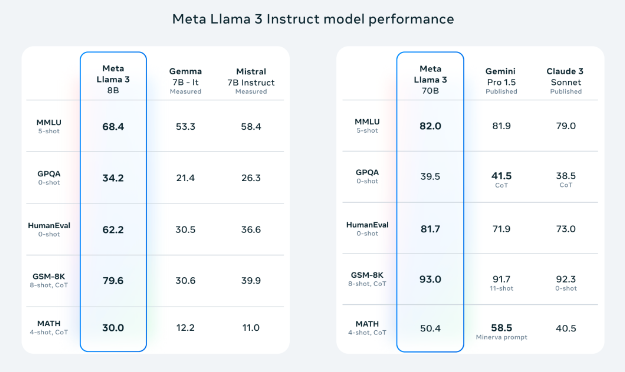

2024年4月18日,Meta发布了最新开源模型Llama 3,这个模型有80亿(8B)和700亿(70B)两个版本的参数。Llama 3是基于超过15万亿(15T)token的数据集进行训练的,数据集的大小是Llama 2的七倍,而且包含了四倍的代码数据。

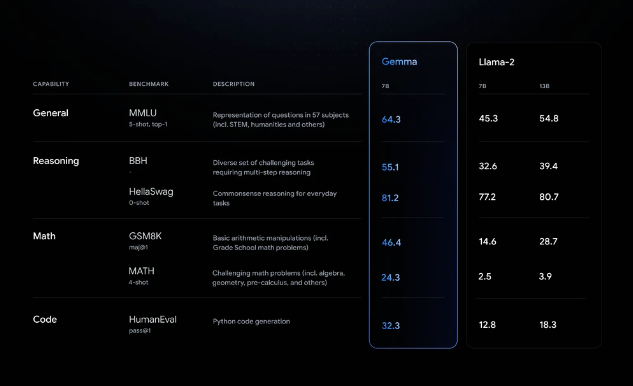

谷歌在2月份开源的Gemma大模型,尝试用2B和7B的参数规模,实现同尺寸范围内的最佳性能。

Mistral AI开源了全球首个“专家混合”架构(MoE)的大模型Mixtral 8x7B,为AI Agent的发展新添了一把火。而hugging-face网站上的开源大模型排行榜,则记录了更多玩家的身影。

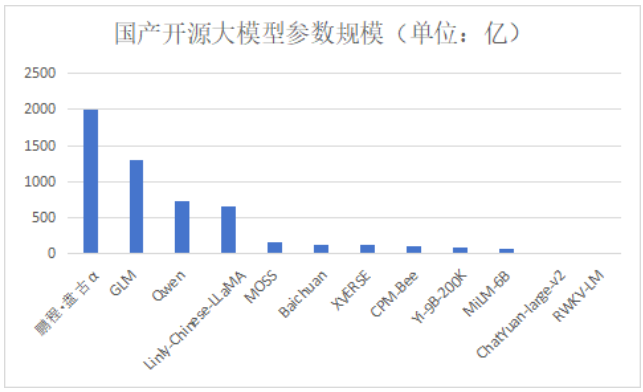

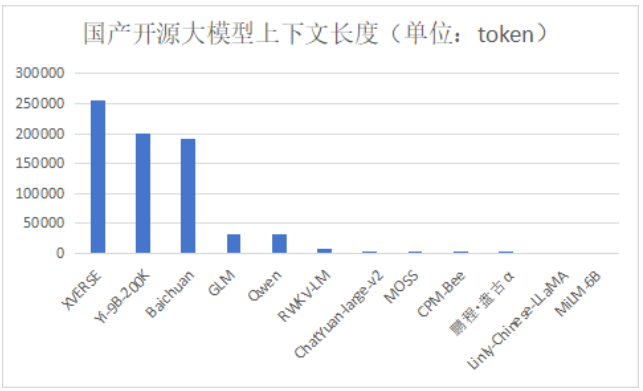

回到国内这边,2022年8月,清华大学开源中英双语预训练模型GLM-130B,使用通用模型算法进行预训练。2023年6月,百川智能发布开源可商用大规模预训练语言模型Baichuan-7B,支持中英双语。2023年10月,智谱AI开源ChatGLM3系列模型。2023年11月,vivo开源70亿参数的大模型。2023年12月,阿里云开源Qwen-72B、Qwen-1.8B和Qwen-AudioQwen大模型。

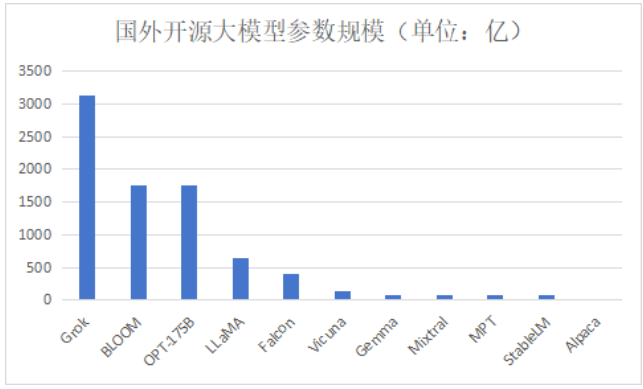

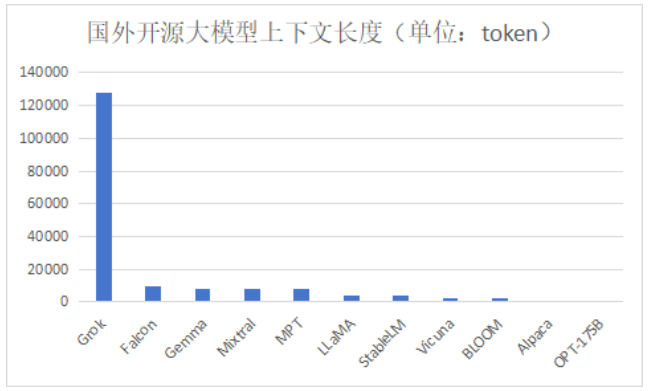

目前大模型的评价指标还没有形成权威的标准,大部分都是在一些测试集上得出结果,而测试集很容易过拟合。借用Moonshot AI/Kimi创始人杨植麟的话说,大模型就像是新时代的计算机,参数规模相当于CPU,上下文长度相当于内存。从这个角度出发,笔者统计了目前国内外主要开源大模型的性能如下(截止到2024年1月):

技术路径选择-开源大模型的多维探索

目前绝大多数的开源大模型都是基于Transformer架构,其主导地位至今无人能撼动。但是反对的声音也不是没有,比如“Transformer的效率太低”、“Transformer无法实现AGI”等等。这是因为Transformer模型的优势同样也是其劣势所在:该模型核心的自注意力机制虽然强大,但也伴随着计算上的挑战。主要问题在于其处理信息时的复杂度是二次方增长的,这导致在处理长序列输入或在资源受限的环境中,所需的计算资源和内存使用量显著增加,这也是造成当下算力短缺的原因之一。

鉴于Transformer架构存在的限制,众多替代性模型应运而生,例如中国的RWKV、Meta公司的Mega、微软亚洲研究院的Retnet、Mamba,以及DeepMind团队开发的Hawk和Griffin等。这些模型都是在Transformer主导了大模型研发领域之后,相继被引入的。

2024年1月,开源RWKV的元始智能完成了种子轮融资。RWKV是一种具有Transformer级LLM性能的RNN。它可以像GPT(可并行化)一样直接训练,并结合了RNN和Transformer的优点。在算力愈发紧张的当下,这样的探索显得尤为必要。

Mega通过其多尺度的解码器架构能够对超过一百万字节的序列进行建模,这使其能够处理比传统模型更长的序列。由于减少了自注意力的计算量,Mega在生成速度上有显著提升。

RetNet是一种新型自回归基础架构,它引入了多尺度保留(Multi-ScaleRetention,MSR)机制来替代Transformer中的多头注意力机制。RetNet在scaling曲线和上下文学习方面表现出色,推理成本与序列长度无关。它在内存消耗、吞吐量和延迟方面优于Transformer,特别是在模型尺寸大于2B时性能通常优于Transformer。

Mamba基于选择性状态空间模型(selective state space model),它可以有选择地决定关注还是忽略传入的输入。Mamba具有快速的推理能力(吞吐量比Transformer高5倍)和序列长度线性缩放的特点。它在语言建模任务中表现优异,可以与两倍大小的Transformer模型相媲美。

Griffin和Hawk模型都使用了一种新颖的门控线性循环层(RG-LRU),这是一种受线性循环单元启发的新型循环层,用于构建新的循环块。Hawk是一个混合了多层感知器(MLP)和循环块的模型。Griffin进一步混合了MLP、循环块和局部注意力,以提高效率。通过结合循环块和局部注意力,Griffin和Hawk在保持RNN的高效优势和Transformer的表达能力的同时,实现了更好的性能和资源效率,特别是在处理长序列和大规模参数时。

而在Transformer架构这条赛道上,不同开源模型的区别主要有三个方面:数据使用、训练策略和优化方法。从上面的表格中也可以看出,很多模型就是基于LLaMA或者Baichuan这样的预训练模型,加入专门的数据集,进行微调得到的。而最终性能指标的PK,背后也就是数据、计算资源、以及算法的激烈竞争。

中美大模型发展对比

中美大模型的对比,简单来说就是应用和基础研发的对比:中国擅长应用落地,而美国则倾向于基础模型研发。但是落实到具体的行业,中美各自的特色才更为彰显。

首先,大模型在不同行业的渗透率存在差异。有两类行业渗透率较高,一类是数据的规模、质量和多样性比较好的行业,如办公、交通等,另一类是技术需求高且创新能力强的行业,如金融、文娱等。

中美大模型在各自行业的发展也遵循上述规律。例如在办公领域,微软已经在Office中全面引入大模型技术,而国内的金山办公等厂商也通过接入MinMax、百度文心等大模型紧随其后。在金融领域,中国农业银行也推出了百亿级参数的ChatABC大模型。这是中美相同的地方。

而不同的地方更有意思。

比如教育行业,美国倾向于利用AI辅助教师工作,而中国更侧重于应试教育。Turnitin公司旗下的Gradescope是一个作业批改模型,好未来推出的MathGPT则是国内首个数学大模型。

在医疗行业中,中国大模型的渗透受到数据制约,进展缓慢,而美国在数据方面的优势使其在医疗研发环节更青睐使用大模型。谷歌的Med-PaLM是其中的代表。

在文娱行业,美国的发展遇到了价值观方面的阻力,中国有望实现弯道超车。携程推出了首个旅游行业垂直大模型“携程问道”,阿里大文娱的“提香”大模型则引领了妙鸭相机产品的流行。

在交通行业,中美两国正处于竞争状态,尤其在智能驾驶领域。基于中国在交通领域丰富的基础数据,以及与电动车、新能源等领域的共振,加上政府在基础数据和算力方面的政策支持,例如北京、上海等城市都发布了支持人工智能发展的具体措施,中国交通领域的大模型发展势必会奏出最强音。

展望未来:开源大模型的发展趋势与挑战

尽管开源大模型能助力中小型开发者,在千行百业里用起来,但笔者认为它们最终无法替代真正的通用大模型。就目前来说,开源模型最大的参数量是3000亿,而GPT-4的参数量估算超过1.8万亿。在性能、通用性以及处理复杂任务的能力上,任何开源模型都无法与那些专门为高级应用和研究而设计的封闭或专有的大模型相媲美。

然而,开源模型仍然可以作为一个很好的起点,就像它过去发挥的作用那样。尤其是在算力短缺的场景下,很多时候我们可能并不需要运行那么大的模型,就像小米在他们的汽车上装配的1.3B模型那样。关键还是创造价值。

结论

虽然中国的开源大模型发布数量众多,但影响力还不及国外的大模型。这一方面是因为国内下游市场巨大,人们更倾向于利用龙头企业的开源模型来做应用落地的创业,而国外则更擅长基础研究。另一方面,由于人才、资本和技术的限制,中国对大模型项目的一级市场投资也不如国外活跃。在行业应用方面,在尊重技术渗透规律的基础上,影响大模型发展的是长期积累的基础数据。

从长远看,中国的人工智能领域在行业基础数据和算力方面仍然存在不足,要扭转这些劣势不是一夕之功。但是立足于自身的特色,尤其是中文的应用落地方面仍然可以领先一步。