本文来自微信公众号“半导体行业观察”。

随着人工智能扩展到新的应用程序,推理和一些训练正在被推向更小的设备。

人工智能在边缘变得越来越复杂和普遍,正在进入新的应用领域,甚至承担一些几乎完全在大型数据中心使用大量数据进行的算法训练。

这一转变背后有几个关键的变化。第一个涉及新的芯片架构,专注于更快地处理、移动和存储数据。这些是数据中心的关键设计目标,定制设计可以加速数据处理和移动,但它们在边缘设备中相对较新——尤其是那些连接到电池的设备——因为之前的大多数设计都专注于处理器的高利用率,这是能源密集型的。

然而,通过将这些设计划分为不同的函数,并使用更稀疏的算法并强制更多的权重为零,执行计算所需的能量显着减少。这反过来又为这些架构在更广泛的应用和市场中使用打开了大门。

Flex Logix软件高级副总裁兼首席技术官Cheng Wang表示:“边缘领域正在发生非常快速的演变。”“如果你看一下5G,它正在向人工智能神经网络方向发展。过去,信道估计全部由DSP处理器完成。现在人们正在谈论运行CNN图。对于5G,大部分秘密在于信道估计——估计信道利用率,然后进行补偿以解决信道中发生的信号失真问题。这在很大程度上与您如何智能地为信号创建最准确的通道模型有关,以便您可以获得最佳的高质量重建。现在正在向人工智能迈进。”

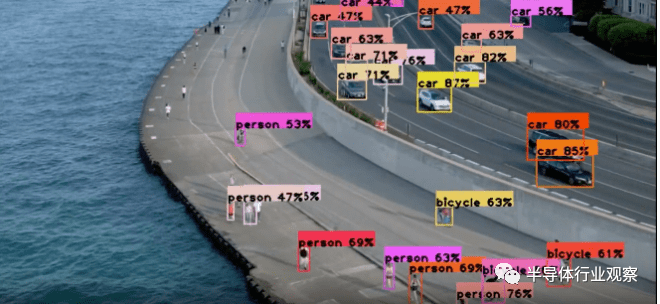

图1:实时识别边缘物体

这基本上是基于向量矩阵乘法的自适应滤波。“目前,5G还没有完全部署,因为它很挑剔,”王说。“大多数高带宽技术需要视距和大量本地无线电单元来提供良好的信道和高带宽通信。但现在他们将使用小型、本地化的无线电单元,这些单元应该无处不在,而不是像高速公路边的塔那样试图为大半径的用户提供服务。”

数据量各不相同

第二个转变是认识到数据量可能会根据应用程序的不同而发生显着变化。事实上,一些边缘设备实际上可以用来训练简单的算法,而不是依赖于数据中心的复杂训练。

“我们正在讨论对简单传感器数据进行培训,”瑞萨电子业务加速和全球生态系统高级总监Kaushal Vora说道。“这些通常不是大型深度学习模型。这些可能是数学模型、基于信号处理的模型以及类似的东西,它们仍在进行机器学习。这些可以轻松地以非常低的功率预算进行动态训练。例如,模型有时会随着环境条件而漂移,而训练时可能没有考虑到这一点。可以通过训练在边缘完成简单的漂移校正。”

其他人则指出了更雄心勃勃的边缘培训目标。Alphawave Semi首席技术官托尼·陈·卡鲁松(Tony Chan Carusone)预测,供应商可能会创建轻量级训练芯片或“推理+”芯片,这些芯片将是带有可以执行训练的附加组件的推理芯片。“Chiplet可能是完美的推动者,因为您可以生成一个具有更多内存的变体来适应这种用例,而无需从头开始重新构建所有内容。您可以混合和匹配现有的东西,制作出超大规模数据中心使用的相同训练芯片的轻量级版本,可能需要更少的内存或更少的计算块,并且能源成本较低。”

然而,基本区别不太可能融合。“训练和推理之间存在很大差异,”Chan Carusone说。“工作量如此之大,即使在大规模并行基础设施上,训练一些最有用的模型也需要几个月的时间。而对于推理,通常强调的是速度、响应度或延迟,你能多快地得出答案。”

但在大多数情况下,边缘的真正价值在于推理。大多数训练仍然是在数据中心使用模型进行的,然后进行超级优化,以允许在边缘进行更高效的计算推理。因此,定制硬件对于推理变得越来越重要。

“我们将看到推理无处不在,”西门子EDA项目总监Russell Klein说。“挑战在于,你是根据非常通用的目的进行推断还是定制它?”

答案取决于应用程序。“你的定制程度越高,你就可以创造出更小、更快、功耗更低的设备,”克莱因指出。“但是你让自己面临可能出现新用例或新算法的风险,而现在你无法在现场改变它。例如,我们可能会创建一个对象检测算法,其中的卷积在硬件中内置了3 x 3滤波器,但它永远无法支持5 x 5滤波器。相比之下,GPU将支持任意数量的滤波器,但它不会那么小且节能。”

这就是边缘定义可能非常令人困惑的地方。边缘从端点一直延伸到云端,可能的应用程序和排列的数量是巨大的。它包括从网络基础设施到使用小型可充电电池运行的设备的一切。

“在网络世界中,一切都是为了通过管道以绝对最小的延迟、最少量的暗硅以最大的利用率尽可能快地移动大量数据。这既描述了网络,也描述了人工智能推理所需的优势,”Expedera营销副总裁Paul Karazuba说道。“它需要能够通过相对较小的管道以极高的利用率极快地移动大量数据。”

与此同时,边缘实施需要克服外形限制和环境波动,而对于仓库规模的气候控制数据中心来说,这些甚至都不需要考虑。“在极端边缘,最大的限制和挑战是在从轻型电池中消耗最少皮焦能量的同时进行有用的计算,”陈·卡鲁松(Chan Carusone)说。“另一个很大的限制是成本,因为这些通常是消费设备。”

这些设备还需要能够解决生成式人工智能向边缘发展的问题,与旧的卷积神经网络(CNN)相比,对变压器模型的需求不断增长,这给设计人员带来了面向未来的挑战。

Untether AI首席执行官Arun Iyengar表示:“如果您的架构无法在两者之间无缝移动,那么它就不会再成功。”“CNN和DNN是计算密集型网络,其中TOPS很重要。相比之下,生成式人工智能是受内存限制的。与您需要通过内存接口引入的数据量相比,需要发生的实际应用程序显得相形见绌。您的架构看起来非常不同。如果你只关注CNN,那么你会发现你无法传输数据,因为你没有足够的高带宽链接到内存,这意味着你无法在大型语言上做任何有意义的事情模型。”

Transformer是两者之间的中间点,包括注意力头等计算必需品,这是神经网络“注意力机制”的关键部分,可引导网络的焦点并帮助其导出模式。Synopsys嵌入式视觉处理器产品营销经理Gordon Cooper表示:“变形金刚在训练期间可以学会关注其他像素。”“注意力网络具有更强的学习和表达更复杂关系的能力。”

Transformer注意力头需要大量的计算吞吐量要求,但它们也会引入大量数据,这些数据会经过等式的内存部分。“书挡是计算端的CNN和内存受限应用程序的大型语言模型。

Transformer和NLP一样,介于两者之间。你必须仔细研究这个范围,并弄清楚你将做出什么选择,”艾扬格说。“例如,当创建CNN引擎时,你的目标是让内存非常接近。您正在传输大量活动系数,并驻留所有权重,因此您可以尽快运行大量此类像素。创建法学硕士时,目标会发生变化。你专注于大型高速公路车道来进行记忆,这也非常快且非常深刻。带宽和密度变得必要,因此您可以尽快从外部提取数据。简单对比一下,如果你用CNN级别的引擎进行录音,那么你在最后20秒所讲的内容就是全部。但如果你做了一个真正的大数模型,具有更高的带宽和更高的内存密度(这就是内存限制芯片所做的),那么你可以回顾整个对话。”

移动数据的成本

第三个重大转变属于移动数据的成本,这就是边缘爆炸式增长的全部原因。移动数据需要消耗资源、能源和时间,并且会增加数据泄露或被盗的风险以及隐私问题。因此,可以在设备上本地完成的操作非常重要。

Chan Carusone认为,强化学习可以与其他方法一起在边缘发挥作用,特别是在涉及专有数据且隐私和安全问题日益严重的情况下。“对此的需求将会更大,因为并不是每个人都会制作自己的大规模生成模型。相反,他们可能会获得许可,并根据其专有数据和用例对该模型进行自己的改进。大型超大规模中心将不断改进和重新训练大型模型,并在其他地方针对公司不想冒险共享的数据进行改进。随着这种技术的发展,你更有可能在边缘看到更有效的方法。”

尽管如此,在边缘运行的模型实际上可能需要更强化的训练。“要建立大型语言模型,培训非常重要且昂贵,”艾扬格说。“但要做一个小模型,训练就更重要了,因为你必须缩小绝对必要的参数范围。而对于大型语言模型,如果您有1.8万亿个参数,那么丢失一些参数也没关系。您的部署(这是一个推论)将在一个非常小的盒子中进行。它需要非常紧凑并且能够执行必要的操作,因此与数据中心内的传统大型语言类型模型相比,边缘应用程序的训练变得更具挑战性。”

未来

虽然边缘人工智能的兴起是一个重要趋势,但总会有一些用例需要数据中心的电源和数据整合。

“如果你正在寻找模式,你必须集体行动,”Quadric首席营销官Steve Roddy指出。“以所谓的‘门廊海盗’为例。如果我有10,000个摄像头进行报告,我就可以找出窃贼挨家挨户偷包裹的位置,并提醒警方他们下一步可能会去哪里。最终,这将是一种相互依赖。您将能够在信号出现时对其进行处理,并且能够在云中分析模式。”

挑战在于找出什么在哪里最有效,因为过于具体也会导致问题。“需要考虑的一个权衡是,您通常无法很好地了解环境中所有事物所发生的情况,”瑞萨电子业务开发经理Nalin Balan表示。“如果您在一台特定设备的边缘进行学习,它可以推广到所有其他端点或设备吗?”

最后,每个人都对这个新领域的快速发展感到既乐观又有点敬畏。Untether AI表示:“如果现在有一个无法在边缘完成的大型语言模型,我可以保证最终会有一个较小版本的LLM,可以在尽可能远的边缘进行推理。”艾扬格。“我坚信推理领域没有限制,我们将通过模型级别或芯片架构级别找到解决限制的方法。”