本文来自腾讯研究院。

随着数字化的深入发展,智能算法已经成为基础性、通用性的技术,持续在经济社会的各个领域应用发展。从互联网领域中的推荐算法、AI生成内容(AIGC),到产业领域中的自动驾驶汽车、医疗AI、工业质检AI,再到社会公共服务中的便民应用,可见算法为数字经济和社会的高质量发展“提质增效”。

与此同时,算法的广泛应用也带来一些负面问题,诸如信息茧房、隐私侵犯、大数据杀熟、算法滥用等。为此,国内外开始探索建立算法治理的新路径新举措,更好地保障可信的、负责任的、以人为本的算法技术创新与应用。

在这些背景下,腾讯研究院法律研究中心研究推出了《人工智能时代的算法治理报告2022——构建法律、伦理、技术协同的算法治理格局》。报告立足于算法的技术趋势和行业应用现状,从法律监管、伦理治理、技术治理三个层面梳理总结国内外在算法治理方面的实践做法,以期通过多元参与、敏捷灵活、精准有效的算法治理,保障算法技术创新与应用健康、有序、繁荣发展。

以下为报告核心内容摘要。

技术趋势:

算法创新推动经济社会智能化发展

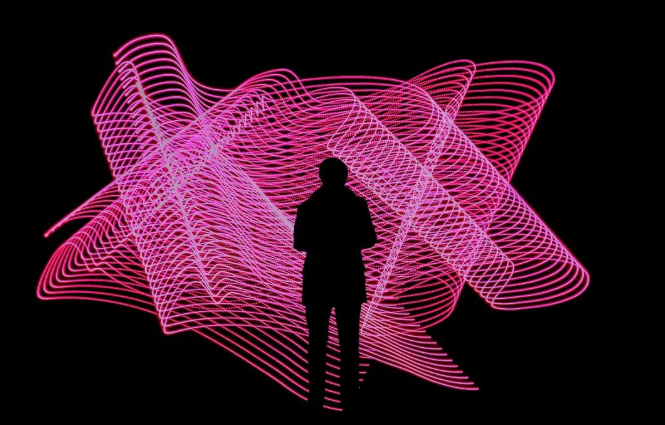

当前,在算法技术创新中,主要有大模型、合成数据和生成性AI三个趋势。其中,大模型无疑是最为重要的发展趋势之一。相较于过去功能较为单一的算法模型而言,大模型具有更强的通用性。因此,大模型也意味着“AI工业化”的到来。AI工业化是指,AI具备了标准化、模块化、自动化的特征,能够大规模地在产业中落地应用。大模型正体现了AI标准化、模块化、自动化的实现路径,并且大模型形成的成本边际效应,极大地节约了AI应用成本。

表:国外主要的AI大模型简表

利用生成对抗性网络(GAN)等AI深度合成技术生产的合成数据,为算法技术创新及其在各领域的创新应用提供了必需的数据源。尤其是在大模型时代,使用合成数据训练的算法模型具有更高的准确性、鲁棒性和通用性。此外,生成性AI也是最新的发展方向,大多生成性AI基于大模型,可以自主生成文本、图像、音频、视频、虚拟场景等多种类型的数字内容,将带来一场零边际成本的内容生产变革,进而给数字内容业态带来巨大影响。

图:Jason Allen用生成性AI绘制的作品《太空歌剧院》,获得比赛第一名

算法技术创新推动算法在经济社会各领域的广泛应用,不断带来创新性应用。例如,算法为产业数字化转型“增智提效”,不仅提升了农业、工业制造等传统产业的效率和自动化水平,也为自动驾驶等新兴产业的发展赋能。同时,算法也逐渐成为数字文化产业创新的基础设施,不断促进数字文化产业繁荣。此外,在推动社会治理现代化方面,算法极大地优化了社会公共服务效率,进一步推动智慧政务“服务下沉”,促使政务信息化、数字化、智慧化成为各级政府改革的刚需。

监管层面:国内外推进

算法立法和监管,积极规范算法应用

目前,国内外都在对算法应用进行不同程度的立法和监管。国内重点针对互联网信息服务算法推荐、分享经济平台算法劳动管理、算法应用中数据竞争、算法推荐的版权治理、深度合成等问题积极探索立法和监管举措。国外则侧重人工智能监管、公共服务中算法应用监管、算法应用中的个人数据保护、算法自动化决策、数字零工经济中的劳动者权益保障等问题。

值得一提的是,在整体的监管路径上,各国存在差异。例如,欧盟正在制定人工智能法案,尝试基于风险等级分类,对所有人工智能应用建立一个统一的、通用的监管框架,但效果和影响还有待观察。很多专家预测,正像之前的数据隐私立法GPDR对全球科技行业的影响那样,欧盟人工智能法案将“布鲁塞尔效应”延伸到AI领域,而这正是欧盟所希望的,即通过监管为全球树立AI治理标准。美英则更加强调监管和行业自律的结合。

例如,美国白宫最近发布的《AI权利法案蓝图》(Blueprint for AI Bill of Rights),明确提出行业主管部门牵头、应用场景导向的分散化监管思路,同时提出5项自愿性的原则。今年7月,英国发布政策文件“建立促进创新的AI监管路径”(Establishing a pro-innovation approach to regulating AI),提出以原则为指导,对AI应用采取促进创新的监管,聚焦具体应用场景,基于风险大小,确保监管的相称性和适应性。可见,美国和英国更加强调行业主管部门牵头、聚焦具体应用场景的分散化监管思路。

伦理治理:从原则走向实践,

更好保障负责任创新

目前,全球各国、社会组织、行业在算法伦理治理上进行了长期探索,从过去积极探索算法治理的伦理原则,到现在逐步开展伦理治理的落地实践并取得阶段性成效。

从全球AI伦理治理来看,已经从原则共识走向治理实践。2021年11月25日,教科文组织第41届大会正式通过的首份人工智能伦理问题全球性协议--《人工智能伦理问题建议书》标志着全球已经就算法伦理治理达成了伦理共识,正在走向伦理治理实践。它不仅制定了首个规范性全球框架,同时赋予各国在相应层面应用该框架的责任,也为规范人工智能发展和应用提供了实践指导和工具基础。

我国也在不断通过政策和立法提出算法伦理治理的要求,伦理治理呈现制度化、法律化的趋势。例如,我国已经组建国家科技伦理委员会,负责指导和统筹协调推进全国科技伦理治理体系建设工作。《关于加强科技伦理治理的意见》则对落实科技伦理治理做出了顶层设计和全面部署,涉及总体要求、科技伦理原则、科技伦理治理体制、科技伦理治理制度保障、科技伦理审查和监管,以及科技伦理教育和宣传等六大方面。《数据安全法》《互联网信息服务算法推荐管理规定》《关于加强互联网信息服务算法综合治理的指导意见》等法律法规和规范性文件,则对数据和算法活动提出了科技伦理治理的要求和措施。

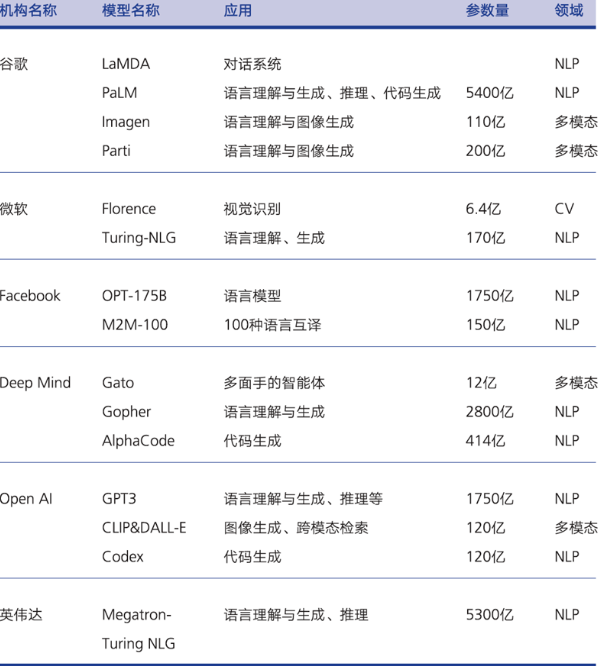

业界在算法伦理治理方面做出了较多的探索。首先,国内外科技企业积极建立AI伦理委员会等科技伦理治理机构,为企业的伦理制度建设、伦理评估与审查、伦理教育与文化建设等提供组织保障,践行负责任的研究与创新理念;其次,业界在AI风险管理机制和AI伦理标准认证方面进行了前沿探索,旨在帮助AI的设计者、开发者、使用者以及评估者更好地管理AI生命周期中可能出现的风险,同时也为对符合伦理标准的人工智能产品、服务或系统进行鉴定认证;最后,针对频发的算法歧视等问题,业界效仿“网络安全Bug赏金挑战赛”的众包模式,开创了算法伦理赏金机制,不仅能快速识别算法问题并改进其产品和服务,也可以提高客户信任度。

图:AI系统生命周期风险管理

技术治理:以可信AI为抓手

打造安全可靠、负责任的算法应用

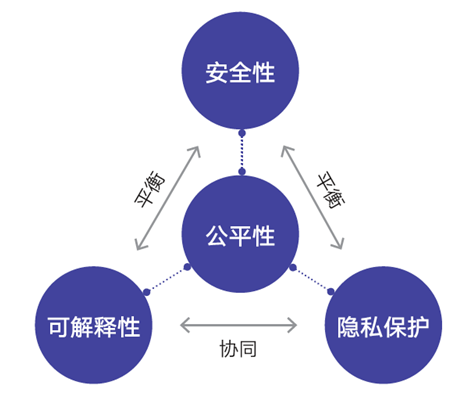

在算法的技术治理方面,可信AI正逐步成为行业规范化、技术商业化的关键助推器,其核心是让AI应用满足公平、安全、可解释、隐私保护等条件,因此也是落实算法治理的重要技术实践。以中国、美国、欧盟为代表的AI领头羊均把可信AI放在AI伦理和治理的核心位置,发展可信AI也正在成为全球的共识。AI企业作为人工智能技术产品化的主体,在可信AI的发展实践中正发挥着日益积极的作用。

图:可信AI研究框架

第一,可解释性。2021年,学界、产业界都在积极探索算法可解释性的技术路径和实践路径,促进算法技术透明。腾讯研究院等发布的国内首份《可解释AI发展报告2022》对此进行了全面梳理,比如,建立“模型说明书”标准,促进算法模型本身的透明度和可理解性,增加相关主体对模型的理解和信任;抑或是打造可解释性工具,推动构建可解释的AI模型(XAI)。

第二,安全性。AI内生安全能力与AI检测工具保障技术安全应用与发展。算法安全主要集中在两个层面。一是,对算法系统本身的保护,保护人工智能训练数据、训练管道和机器学习模型,即AI内生安全。对于AI内生安全,企业和科研团队都给予高度关注。例如,腾讯朱雀实验室不断探索高阶的算法模型攻击模式,如“AI供应链攻击”、“重构模型后门攻击”、“数据木马隐藏攻击”等。二是,研发检测识别工具来促进生成性AI算法和AI生成/合成内容的安全可控应用,应对深度伪造、AI换脸、AI欺诈等算法恶意使用的行为。

第三,公平性。目前可信AI在促进算法公平性上有很多的创新和实践,主流的是从数据和算法两个方面入手,如使用族群、性别等属性均衡的数据集,在算法模型中增加约束或正则项消除偏差等。与此同时,公平性检测也是促进算法公平的重要实践方式。业界不仅推出了基于不同纬度和视角的公平性测试的数据基准,而且陆续也在推出公平性测试的算法、工具等。

第四,隐私保护。业界分别从数据、算法两个方面进行可信AI隐私保护的技术创新和部署:在数据方面,主要包括差分隐私、合成数据、同态加密(HE)、匿名化等技术手段;在算法方面,以隐私计算为主要领域,主要包括了安全多方计算、零知识证明、联邦学习等。

第五,可信AI的发展过程中,算法伦理服务市场也在同步兴起。未来国内外大型科技企业不仅会提出更加完善的AI伦理解决方案来服务于企业内部的技术研发和产品业务稳定发展,它们也会将这些AI伦理解决方案和经验包装成可复制、可推广的服务产品,去赋能更多的人工智能科技企业和产品。同时,也会有更多的创业者涌入这个领域,围绕AI伦理服务进行创业。

展望:走向法律、伦理、

技术协作互动的算法治理实践

面向未来,灵活有效的算法治理离不开法律、伦理、技术等多种治理手段的协同作用,也需要监管部门、行业和企业、研究机构、社会组织以及社会公众等多元主体的共同参与。仍需坚持以人为本、科技向善等理念,实现算法创新应用和安全之间的平衡发展。

在法律治理方面,需要采取分场景分行业的分级分类监管思路,划定算法应用的底线,形成敏捷的、精准的长效监管和治理机制,探索政策指南、监管沙盒、安全港、试点、标准认证、事后追责等多元化的监管措施,确保算法技术创新与应用发展既生机勃勃又井然有序。

在伦理治理方面,随着算法技术与人类社会的深入融合、未来数字科技逐渐走进“深水区”,以算法伦理治理防范算法风险、推动负责任创新,已经成为各国政府、科技企业的共识。未来,算法伦理治理的制度建设会逐步完善,内部建设主要以机构内的科技伦理委员会为载体,外部建设有第三方伦理认证等探索性尝试。

在技术治理方面,以技术创新解决技术应用带来的问题是算法治理实践的关键一环,能够打通抽象的治理原则和具体的技术实践之间的鸿沟。围绕可信AI及应用,未来会有更多伦理性的技术工具、技术解决方案。伦理设计的理念和实践正在与技术治理、技术创新紧密融合。越来越多的伦理考量将进入到技术的研发设计过程中。