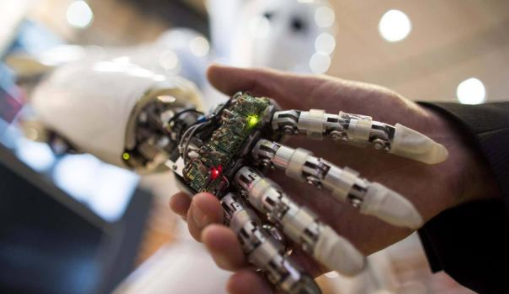

随着科技的发展,人工智能技术,开始深入人们的生活。它虽然没有像科幻电影里一样,出现在人们的面前。但是现实中,的确存在着。而在这些技术发展过程之中,也存在着一些需要提前解决的问题。例如脸谱网在发放广告的时候,就会对用户进行解释,为什么会遇到这样的广告。而正式因为有一些,对人工智能算法有所疑虑才会如此。

01

一、谨慎对待决策研究

没有公司愿意被视为,是在延续陈旧思想,或根深蒂固的社会不公。因此公司可能不愿分享,其决策算法的具体工作原理。以避免被指责为,不公正的歧视。公司也可能不愿为,所做的决定提供解释。因为这些信息,会使外部人员更容易,对他们的专有系统进行逆向工程。

在北卡罗来纳州达勒姆的杜克大学,研究可解读机器学习的,计算机科学家辛西娅鲁丁(Cynthia Rudin)。曾经表示过:“有关信用评分的解释令人极其不满意。”。她认为信用评级机构,故意掩盖其基本原理。他们不会告诉你,他们是怎么计算的。那是他们的‘秘诀’,对吧?从这里我们也可以感受到,一些人的警觉心理。

之所以要谨慎,还有另一个原因。一旦人们对某个决策系,统进行了逆向工程。就会更容易,开始选择玩弄它。事实上围绕这一点,已经有了一个名为“搜索引擎优化”的庞大行业。该行业会对网页,进行表面上的修改。使其在搜索排名中,可以变得名列前茅。那么,为什么一些使用决策人工智能的公司,如此热衷于提供解释呢?

为了找出答案,剑桥大学的计算机科学家乌曼。及其合作者采访了30家机构,50名科学家、工程师和高管。他们了解到,一些高管要求其数据科学家,加入可解释性工具。这样公司就可以,宣称自己使用了透明的人工智能。数据科学家们并不知道,这是针对谁的。需要什么样的解释,也不知道公司为什么要开放。

“基本上,高层都喜欢,可解释性的花言巧语。”巴特说,“而数据科学家,则会争先恐后地,想办法实现它。”数据科学家们的解释,五花八门,但大多分为两类。

一类是对基于人工智能的系统,如何运作的解释。另一类是对特定决策的解释。它们分别称为,全局解释和局部解释,两者都可以被操纵。

位于魁北克大学的乌尔里希阿沃吉(Ulrich Avodji),和他的同事演示了如何修改全局解释使其看起来更好。他们使用了一种被称为,LaundryML的算法(该算法对这种公平清洗来说已经足够合适)。来检查因内部运作过于复杂,人们很难识别的机器学习系统。研究人员采用了LaundryML,来应对XAI研究经常遇到的两项挑战。

02

二、对挑战的研究工作

第一项任务是根据,个人的各种属性来预测,某人的收入是否超过5万美元。可能使此人成为一个,良好的贷款候选人。

第二项任务是根据一组不同的属性,来预测罪犯在出狱后的两年内,是否会再次犯罪。与通常用于生成解释的算法不同,LaundryML包含了某些公平性测试。以确保解释(原始系统的简化版本),在预测收入和累犯时,不会优先考虑性别或种族等因素。

借助LaundryML,研究人员,能够得出简单的规则列表。这些规则列表,看起来比原来有偏见的,系统公平得多。但其给出的结果,基本相同。令人担忧的是,企业可能会将这样的,规则列表作为解释。以证明自己的决策,体系是公平的。

机器学习系统整体操作的办法是给出其决策抽样。机器学习系统整体操作的办法是给出其决策抽样。

2020年2月,日本理化研究所高级情报项目中心研究员福地和人(Kazuto Fukuchi)及其两位同事介绍了一种方法,该方法可以从以前的决策中选择一部分,这样一来,在判断系统是否不公平的审计员看来,该样本就具有代表性了。虽然精心挑选的样本符合某些公平标准,但这不代表整个决策集都符合。

各组织机构需要更频繁地,为个别决策提供解释。而不是解释其系统是如何工作的。其中一种技术。依赖于XAI研究人员称为。“关注”(attention)的东西、它反映了决策系统的,输入部分和输出部分之间的关系。

他们认为关注值表明了,最终判断对某些属性的依赖程度。但是卡内基梅隆大学的扎卡里立普顿(Zachary Lipton),及其同事则对“关注”的整个概念表示怀疑。

这些研究人员训练了,各种神经网络阅读医生的简短档案。并预测这些医生中,谁擅长外科手术。他们会确保这些网络,不会关注表示性别的词语。一个只考虑关注因素的解释,会让人觉得。这些网络并没有性别歧视。

但奇怪的是,如果在档案中删除,“女士”这样的词。预测准确性就会受到影响。这表明该网络,实际上仍在使用性别,来预测一个人的专长。

结语:我们并不清楚“关注”指标,实际上指的是什么,这就为欺骗打开了空间。不过即使是,不完整或误导性的解释。它们对于调试和推动,公平也是有价值的。借用一句有时用于描述,统计模型的格言:所有的解释都是错误的,(包括解释人工智能黑匣子工作原理的简单解释),但有些是有用的。因此对于人工智能市场来说,未来发展的时间还很漫长。