低能耗的数据中心需求不仅关系到了人类环境的可持续发展,也直接决定了算力的成本和服务的竞争力。

01

数据中心面临的挑战

上世纪60年代也就是最早的互联网大型机的时代,不超过100万节点进行连接。80年代差不多有一千万,90年代差不多有一个亿。2000年进入了熟悉的桌面互联网,差不多10亿设备进行互联。

2010年进入移动互联网时代,有100多个亿设备进入互联网连接。最新IOT时代,不仅是手机,还有我们的电脑和家电,所有设备都会连接到了互联网,超过500亿设备连接到互联网连接数量成倍的增长。

大数据、云计算的快速发展,让世界变得更加互联,人类生活感觉到更加便捷的同时,背后产生越来越多的数据。数据以难以想象的速度快速增长,国际数据公司最新统计和预测,全球数据会从2018年32ZB增长到2025年的175ZB。数据成倍的增长,将会需要越来越多的计算能力进行运算和处理。

回顾近几十年处理器的发展,摩尔定律逐渐放缓,当摩尔定律放缓以后,想追求更高的计算力,散热和能耗遭遇到挑战。云计算资源集中化,高密度提升必然会带来单个服务器和机柜的功率的上升,对支撑服务器稳定运行的数据中心也会有巨大的能耗挑战。另外,数据中心的耗电量占4%左右。低能耗的数据中心需求呼声越来越高,不仅关系到了人类环境的可持续发展,也直接决定了算力的成本和服务的竞争力。

上海市最近发布了新建数据中心PUE严格控制在1.3以下。国家对新基建时代的能耗,以及各地政府对能效的要求也越来越严格。对未来大数据,大规模的数据中心的建设会更加严格的控制,我们不得不对挑战进行不断地探索。

既要解决高密度的计算问题,又要解决能效的问题,成本更低,可靠性高,这是未来数据中心的挑战,倒逼我们不断的思考和探索未来下一代的数据中心怎样解决挑战。

02

风冷不冷液冷才是冷

为什么用液冷?就目前可行的产业方向看,大多数的企业都是从两个大的方向上努力:

第一:CPU芯片持续改进,可以增大芯片的面积,增加芯片的尺寸,但同样带来负面效应。

第二:液体代替空气冷(风吹)却介质,通过液体对比空气的性质,可以提升能力,这是提高散热效率的关键点。常规的冷却是空气冷却,冷却介质就是空气。

阿里云基础设施服务器研发架构师钟杨帆说:“液冷就是通过液体,比如说水或者说其它的特殊不导电的液体代替空气,将芯片内存以及CPU等发热部件的热量直接带走,而不通过传统的低效的空气。”

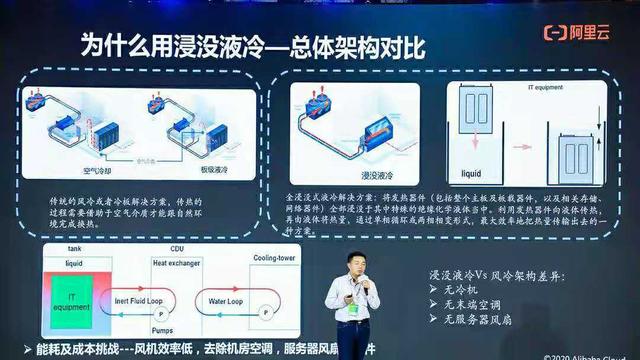

阿里云在面临这些问题的时候,也是在不断的思索,不断的探索和尝试。现在大规模使用的空气冷却的技术架构,使用空气介质作为传导。整体的架构可以看到,浸没液冷代替了空气介质,提高了冷却效率。从架构上看,这是做了很大的减法,完全排除了能效比较低的冷却设备,比如说风扇和空调。

从风扇、硬盘、CPU等等角度看,传统的冷却都是空气将热量带走,少量的部件通过液体带走。如果采用了一种介质或者说采用了一种技术可以完全的替代空气,能够使得热量完全的从液体上带走,这样的冷却效率会大幅度的提升,以及达到一个极致的冷却效果。

与此同时,未来服务器的数量会越来越多,规模会越来越大,除了考虑可靠性的问题,还需降低失效率。

传统空气冷却的影响失效率的因素看,主要是温度、振动、粉尘、潮湿。在数据中心里,失效率最高的是硬盘失效。温度提高对硬盘的失效率故障显著增加。未来如何通过温度的适当降低,同时减少振动粉尘和潮湿的因素影响,提高数据中心的可靠性和降低失效率这是一个值得研究得课题。

03

“泡”澡效果最好但挑战仍然很多

阿里云从2015年开始对比了不同的冷却架构,包括空气冷却,冷板液冷,从不同的维度进行总结和对比。从空气冷却到冷板液冷,从各个方面进行对比,实践中不同的尝试着验证迭代,结果证明:浸没液冷是数据中心的一个跃迁式的技术创新,具有高可靠、高可用的特点。

一项新的技术在规模不大的时候,可能不太容易发现问题和所面临的挑战,但一旦规模大了以后,我们要看在实际的应用过程中会出现什么样的问题,怎么解决规模化的挑战。

浸没液冷的技术优势,之前基本上没有看到在互联网数据中心大规模进行部署,液冷领域很难看到大规模的部署数据中心。钟杨帆说:“现在很多问题没有说非得用液冷解决,牵一发而动全身,面临一些全新的挑战,这是革命性的变化,这仍然一个很大的工程。”

先看基础设施是否可以达到与风冷同样的可靠性,如果可靠性很差,问题就很大。介质变了,放在液体中是不是可以长期稳定的工作,液体是不是不导电?很多的全新领域都需要解决。

再就是运维的挑战,因为密度高了以后,它的重量也会更重了,如何维护?

在基础设施里,完全的重构,把数据中心和服务器融合在一起去考虑,全部整合在一起做重构,以及极简的设计。

04

冷却不再靠天

阿里云2018年部署的张北数据中心,为了降低能耗,实现节能环保的探索。最早2017年建立了互联网行业的服务器集群是在杭州。2018年开启了液冷的商用,包括了计算、存储、网络,全部都实现了浸没液冷的转化。杭州,今年刚刚建设成的一个全球规模最大的浸没液冷数据中心,这是全中国首个绿色数据中心。

“我们对比测算过了,如果相比传统的数据中心,阿里云这一个数据中心每年可以节省至少上千万元元的电。经过长期、规模化的部署2-3年的时间,高密度通过高效液体冷却可以打破空气冷却瓶颈,在单机柜的功率密度可以提升3倍以上。”钟杨帆表示。

高可靠,硬盘、内存和CPU进行对比,通过全密闭的浸没实验的技术,可以降低整体的部件失效率达到50%以上。高能效,我们对能效也是不断的追求的指标,通过数据中心IT设备冷却一体化的架构创新设计,根本上去除低能效的部件。除了服务器以外,整体的能耗可以下降40%左右。高可用,自然冷却高度依赖气象条件,很多的数据中心选择了比较冷的地方,靠近北极,就是为了利用当地比较优的自然环境。

浸没冷却完全是不再依赖任何的气象条件,可以在高温,高湿,以及在腐蚀性,海边的恶劣的环境中进行运行。大多数数据中心,里面的噪声很吵,这是风冷数据中心的特点。因为风冷需要风扇,所以会有声音。虽然说进去以后非常吵,令人厌烦,但无可奈何。

钟杨帆说:“进入浸没数据中心以后,你会发现基本上没有声音了,这是非常安静的,对运维人员是比较大的改善。”

05

结语

液冷这个新的行业,因为它要革命性地变迁,必须得重塑发展,然后进行推广和扩大。希望所有的行业伙伴一起可以参与进来建设整个行业生态,能够助力新基建,帮助数据中心能够达到节能绿色环保。