在科幻大片《终结者》(Terminator)中,机器人想完全占有这个世界,把人类赶尽杀绝。对此我们不禁要问:“如果电影中场景在现实重演,结果会怎样?”提出这样的问题不应该受到指责,因为通过电影和科幻故事,机器人接管地球的场景几乎无处不在,因此我们对人工智能(AI)的未来已经形成了这样的印象。然而,既然人类能够通过法律维持生存和合作,为何不能把法律也应用到AI身上呢?这就涉及到阿西莫夫的机器人三大定律!为了更好地了解未来,我们首先要回顾下过去。

三大定律

艾萨克·阿西莫夫(Isaac Asimov,1920-1992)除了是一名生物化学教授,还被认为是他那个时代的“三大”科幻小说家之一。在20世纪中期,阿西莫夫提出了三条定律,如果遵守这些定律,我们就能阻止机器人起义。这三大定律包括:

第一定律:机器人不得伤害人类,或因不作为而让人类受到伤害;

第二定律:机器人必须服从人类给它的命令,除非这些命令与第一定律相冲突;

第三定律:机器人必须保护自己的存在,只要这种保护不与第一定律或第二定律相冲突。

现在,如果你熟悉编程,你就会知道机器会从0开始计数,而不是从1开始。因此,正如电脑迷所说的那样,第0条法律指的应该是集体而不是个人。如果这些定律听起来很熟悉,那是因为它们是在《我,机器人》(I, Robot)这个故事中出现的。值得注意的是,它们在“机器人”(身体)和“人工智能”(大脑)之间并没有区别,因为当阿西莫夫提到机器人时,他脑海中出现的是智能类人生物。

那么,如果早在20世纪50年代这些定律就已经被制定出来,为何我们还如此惧怕机器人呢?是什么促使埃隆·马斯克(Elon Musk)甚至斯蒂芬·霍金(Stephen Hawking)将AI视为人类“最大的生存威胁”?长话短说,这是因为阿西莫夫的三大定律不起作用。

计划中的缺陷

回到现在。为了与阿西莫夫的观点保持一致,让我们假设我们确实有足够复杂的AI代理来适应这些定律。为了便于讨论,我们还假设,尽管它们是叙事机制的法则,但它们也适用于现实世界。

技术问题:如果法律是英文的,而AI代理只能处理中文会怎样?或者即使代理是在美国制造的,我们怎么知道它如何理解法律?因此,我们需要一种方法来(i)把法律翻译成每一种可能的语言,(ii)把这些词背后的含义传达给每一种可能的语言(为了涵盖所有可能的情况,还必须使用拉丁语等已经消亡的语言以及二进制机器语言)。

对于人类来说,这些任务是息息相关的。但对于机器来说,这是两个截然不同的任务。第一个任务是用不同的语言生成相应的句子字符串,第二个任务是理解这些字符串。如果我告诉你用西班牙语唱《Despacito》,就好比只做第一个任务。你可能说得很好,但你却不知道它们的意思(假设你不懂西班牙语)。另一方面,只做第二项任务就像脑子里有了一个想法,却不知道如何表达。

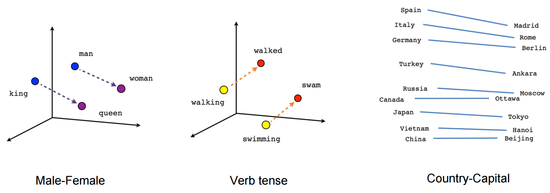

幸运的是,自然语言处理(NLP)领域在过去的几年里经历了巨大的飞跃。对于第一个任务,具有长短期记忆细胞(Long Short-Term Memory)的神经网络可以用序列-序列的转换方式。此外,端到端的语音-语音翻译模型Translatotron,于上个月(2019年5月)发布。对于第二个任务,Word2Vec模型已经证明了自己的价值,它将相关的单词组合起来,从而在句子中产生语义。如下图所示:

的确,机器现在可以理解语言。然而,它们仍然有很多事情不能做。一个例子就是理解习语。虽然“spill the beans”可能是“泄露秘密”的比喻意,但目前还无法进行比喻翻译。因此,机器将逐字逐句地把每个单词翻译成对应的单词。如果按照正确的顺序翻译成法语,那么这个表达就是“jeter les haricots”,这听起来肯定给人一种断章取义的感觉。

但是,为了便于讨论,让我们大胆假设,比喻翻译问题将在未来几年得到解决。这样一来,所有关于让AI代理理解法律的技术问题都会得到解决,我们也就安全了,对吧?做好准备,因为这才是有趣的地方!当阿西莫夫提出这些定律时,他不知不觉地把它们建立在另一个假设的基础上:我们人类确切地知道道德底线应该划在哪里。但是我们会遵守吗?

让我们以第一定律中的“伤害”一词为例。在这个定律中,让我们也考虑一下“人”这个词的含义。它的定义包括什么?例如,在14世纪,奴隶被认为比更接近牛等牲畜。现在,胎儿的生命权是许多讨论的主题。然而,将来,如果一名孕妇由于某种疾病,在分娩时死亡的几率很高,她的AI医生应该建议堕胎吗?人们需要记住的是,虽然从逻辑上讲,女性在堕胎中存活的几率更高,但胎儿一旦出生,就有更多的生存空间。所以,不管怎样,机器人最终伤害了人类。

接下来的决定甚至会让我们人类陷入否认的状态。让我们考虑一下丹·布朗(Dan Brown)描述的地狱场景,并应用第零条定律。AI将显示一个按钮,并被告知,如果它按下按钮,一半的人类会立刻死亡,但是这个物种会存活几个世纪。如果不这样做(因此,不作为),人类将在50年内达到人口过剩状态,我们的物种将崩溃。如果你处在AI的位置,你会怎么做?

结论

阿西莫夫的机器人定律试图解决AI起义的威胁。使机器人遵守这些定律的技术障碍是我们目前在使它们理解法律方面的限制。真正的障碍(哲学和伦理上)可能是我们的假设,在如此模糊的限制下,机器人将会按照我们想要的方式行动,即使我们不知道自己的意思。即使我们传达的意思是正确的,这些定律也可以简单地改为“不管怎样,只要做好就行,对吗?”而到那时,它们可能已经造成了不可挽回的影响。 (选自:towardsdatascience. 作者:Hans A. Gunnoo 编译:网易智能 参与:小小)