人工智能训练另一个你,人与人之间姿势传递的最近邻和生成模型摘要:我们调查人与人之间传递姿势的最近邻和生成模型。 我们拍摄一个人执行一系列动作的视频,并尝试生成另一个人执行相同动作的视频。 我们的生成模型(pix2pix)在两个生成相应的框架上均优于k-NN,并且在所演示的动作集之外推广。 我们最重要的贡献是确定能够有效执行所需任务的流水线(姿态检测,人脸检测,基于k-NN的配对)。 我们还详细介绍了几种迭代改进和失败模式。

人工智能训练另一个你,人与人之间姿势传递的最近邻和生成模型简介:姿势转移是各种应用程序的问题,这些应用程序会推动图像或视频生成的边界。首先,在一个人不能执行特定的一系列动作的情况下,能够转移姿势是有用的。这对视频制作和编辑尤其有用(例如,增强用于电影的特技双打制作的素材)。从计算机视觉的角度来看,这个问题也是非常具有挑战性的,因为难以可靠地检测到关节位置,并且能够将姿势从任意人转移到另一个人。最后,姿态转换构成了我们是否能够信任我们在互联网上看到的图像和视频的道德困境。最近引起广泛关注的“深层次假说”强调了这方面工作的必要性[10]。

人工智能训练另一个你,人与人之间姿势传递的最近邻和生成模型。贡献:我们的目标是从个人A的视频中执行一系列行动,并将个人B的视频执行相同的行为。我们开发了三个关键的定性指标来衡量模型输出视频的质量:

1.平滑视频:单独的帧将被分开计算,因此高质量的视频将在帧之间平滑过渡。

2.锋利的边缘:生成的个体的轮廓应尽可能清晰逼真

3.最小的伪影:模型应避免产生明显的视觉伪影,降低输出质量我们试图优化我们的模型以尽可能最好地处理所有这三个指标。

人工智能训练另一个你,人与人之间姿势传递的最近邻和生成模型。pose2pics:pose2pics模型牺牲了输入中的一些准确性和信息来推广输入空间。在图5中,第一行显示了一个有效的转移,其中姿势模型准确地表示了真实的姿势,并据此进行转换。教授Alexei Efros的姿势相同,输出只包含较小的伪影。然而,这个模型也更容易受到不可预见的情况的影响,例如在姿势骨架中丧失肢体。在第二行中,我们看到个体的右臂没有被姿势骨架捕获,使得pose2pics模型在生成的图像中截断了肩膀处的手臂。这首先表明,该模型严重依赖联合空间数据作为生成真实图像的框架,其次证明不恰当的训练/测试数据导致输出大大偏斜。我们还注意到,当我们通过从具有明显不同骨骼结构的人生成的骨骼时(例如,某个人比我们最初训练的骨骼的人脚高),输出图像将具有明显的物理异常(例如,细长的肢体)。为了解决这个问题,我们可以训练一个更加多样化的姿势骨架集合(希望能够引导模型学习肢体长度不变的变换),或者在关节角度而不是位置上训练模型。我们也注意到pose2pics正在努力通用化,以前所未有的位置。更多样化的培训集可能有助于缓解这个问题。

人工智能训练另一个你,人与人之间姿势传递的最近邻和生成模型。pics2pics:使用直接图片生成图片,我们发现我们在图片方面获得了相当有希望的结果。如图6所示,它们看起来相当逼真且具有锐利的边缘。大部分原因在于,它避免了姿态骨架生成器作为中间步骤,该步骤会引入噪声并大大减少信号。我们还观察到有条件的GAN的泛化,尽管在训练数据中他从未见过Efros的双臂,但他已经学会了将Efros的双臂提高到头顶。

然而,这种方法并不像其他方法那样不依赖于背景或服装,因为它取决于给定位置上特定个体的非常严格的输入格式。该模型适用于需要长时间和详细的个人培训视频的简单应用,并且该模型仅用于在两个特定人员之间转移姿势的目的。这可能对于制作一个演员从执行相同动作的特技视频中演绎的技巧非常有用,正如我们介绍中所提到的。

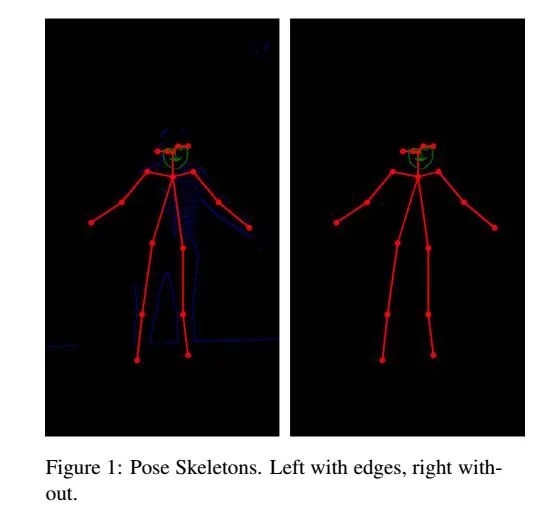

人工智能训练另一个你,人与人之间姿势传递的最近邻和生成模型。结论和未来的工作:在本文中,我们探讨了k-NN,pose2pics和pics2pics模型在视频之间的姿势转移问题中的应用。作为基线,k-NN将姿态骨骼生成器识别为姿势传输管道中的薄弱环节。姿态骷髅的嘈杂对跳跃转变和输入 - 输出匹配有着巨大的影响。这使得k-NN姿势转换变得困难,即使对于训练数据集中的姿势空间部分。

但是,我们仍然能够从我们的实验结果中解脱出一些有用的经验教训并且有希望开始。生成的pose2pics模型图像表明,神经网络有可能学习一个人的结构,然后在给定特定的姿势骨架时使用该结构生成图像。此外,pics2pics模型证明条件GAN有能力从训练数据中推广以生成超出训练分布的图像。我们预计完美姿态骨架生成算法将能够生成更好的训练对,从而进一步提高两种模型的效能。

一个明显的改进领域是降低我们方法的时间复杂度,以便我们可以实时生成视频。我们实现了先前讨论的pose2pix流水线的基于网络摄像头的版本,但无法将帧生成时间降低到一秒以下,比典型帧速率慢30倍。探索视频之间姿态转换的一个特别令人兴奋的方法是利用帧之间的时间一致性。在一个瞬间和另一个瞬间之间,视频不太可能改变(因为我们以60 FPS录制)。我们可以在框架后面维护一个基础结构。然后,使用基于压缩神经网络的方法甚至纯算法(如卡尔曼滤波器),我们可以生成当前帧和下一帧之间的差异。这样,我们就能够生成流畅的视频,而只需要在移动对象的边界执行计算。理想的情况是,这会让我们更接近实时传输的目标。

此外,虽然我们选择在我们的流水线中不包含边缘检测,但如果能够在增强监视和边缘检测提供的过度拟合之间找到适当的平衡点,则可以产生更多的实际输出。一个可能的方法是从各种各样的输入源传入姿势骨架,以便模型学习忽略边缘图像的非关键部分。

最后的改进是使用更好的姿态估计模型。我们使用标准工具(如OpenPose)完成了大部分项目,但姿势输出中的噪声导致了影响我们的k-NN,Pose2Pics和Pics2Pics模型的大部分问题。我们最近发现了一个更强大的模型[9],它非常精确。它从2D视频生成三维姿态估计,并使用1欧过滤器来避免噪声姿态估计的问题。利用这种姿态估计器,我们可以设计更强大的k-NN方法,利用关节角度空间中的距离,而不是关节位置空间。如果我们尝试在高度差异很大的个体之间进行翻译 - 例如Joshua Hug教授和John DeNero-k-NN教授在关节位置空间中无法准确地配对图像。通过在角度空间中工作,我们的姿态传输方法可以对物理属性的差异保持不变。这个更强大的k-NN会产生更好的训练对,所以条件GAN可以训练完美的数据。