本文来自微信公众号“陈述根本”,作者/陈根。

在数据增长、算法精进的背景下,算力成为了数字经济时代的“新能源”。算力时代正在加速到来。

小到智能电脑、智能手机、平板等电子产品,大到天气预报、边界出行、医疗保障、清洁能源等民用领域拓展应用,都离不开计算的赋能支撑。计算已经实现从“旧”到“新”的彻底蜕变,成为人类能力的延伸,赋能数字经济各行各业的数字化转型升级。

然而,一方面,随着全球化以及科技的高速发展,需要处理的数据量在急剧增加——IDC早前发布的《数据时代2025》报告指出,全球每年产生的数据将从2018年的33ZB增长到2025年的175ZB,相应的数据处理模型和算法也在不断增加,带来的结果就是对算力和功耗的要求不断提高。

另一方面,半导体光刻工艺水平的发展是以芯片为核心的电子计算机的基石,目前半导体光刻的制造工艺几乎是摩尔定律的物理极限,随着制造工艺的越来越小,芯片内晶体管单元已经接近分子尺度,半导体制作工艺的“瓶颈效应”越来越明显。

因此,如何提高运算速度同时降低运算功耗是大数据时代面临的紧要问题。

面向未来的计算系统,光作为宇宙里速度最快的事物——它在空气中以30万公里/秒的速度传播,似乎具有天然的优势。光子具有光速传播、抗电磁干扰、任意叠加等特性,光学计算具有天然的并行计算特性,因而运算速度极快,且十分适合做并行运算。

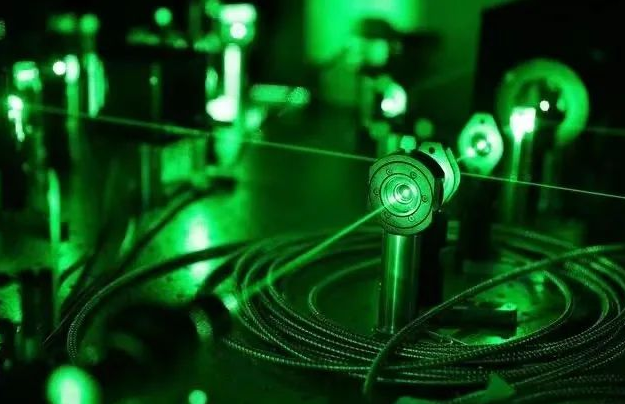

而激光作为原子受激辐射的光更是备受科学家的关注。近日,来自弗里德里希-亚历山大-纽伦堡大学(FAU)激光物理学教席的研究人员和纽约罗切斯特大学的一个团队宣布,他们已经证明了未来如何利用激光脉冲将基本计算操作的速度提高到一百万倍。

具体来看,电子学被设计用来传输和处理逻辑信息形式的信号和数据,其使用二进制逻辑。另外,这些信号也可以采取电流脉冲的形式。而激光物理学教席的研究人员几年来一直在研究如何将光波转换为电流脉冲。

研究人员在他们的实验中使用超短激光脉冲照射一个石墨烯和金电极的结构。激光脉冲在石墨烯中诱发电子波,这些电子波向金电极移动,在那里它们被测量为电流脉冲并可被作为信息处理。

根据激光脉冲击中表面的位置,电子波的传播方式不同。这就产生了两种类型的电流脉冲,它们分别被称为实电荷和虚电荷。

此次,FAU的激光物理学家就通过他们的实验首次证明了一种新的方法可以用来操作逻辑门——计算机处理器中的一个关键元素。

逻辑门规定了如何处理传入的二进制信息。该门需要两个输入信号,这里是来自实电荷和虚电荷的电子波,由两个同步的激光脉冲激发。根据这两个波的方向和强度,产生的电流脉冲要么被聚集要么被抹去。再一次,物理学家测量的电信号可以被解释为二进制逻辑,即0或1。

研究人员表示,通过基础理论及其与实验的联系,他们已经发现了真实和虚电荷的作用,这为创建超快逻辑门开辟了道路。当然,虽然可能还需要很长的时间才能在计算机芯片上使用这项技术。但至少这已经给出了一个信号,光波电子学是一项可行的技术。