本文来自与数据同行微信公众号,作者/ 傅一平。

自2022年11月ChatGPT发布以来,国内大模型如雨后春笋般,层出不穷。据统计,截止至2023年5月,国内至少有55个类GPT大模型已经推出或马上面世。互联网/云服务大厂、AI企业、传统行业公司、大数据公司以及算法公司几乎全部入局。应该来讲,探索一下大模型本身也没什么问题,没搞过就不知道大模型有多强大,但大模型的赛道并不适合大多数企业。

事实上,未来大模型的赛道将转向领域大模型,企业更应关注的是:如何站在通用大模型的肩膀上,基于自身的业务和数据打造出独特的领域大模型,从而获得差异化竞争力。

一、通用大模型门槛很高

“今天的初创公司,很多叫做大模型的,包括创业者,也包括互联网大厂我们都不投。”某基金董事长表示只会投有数据的具体应用,但不投大模型。

“历史上创业公司能够成功很大的原因是你‘为别人所不敢为’,或者做别人认为不会起来、不太看得重的东西,这一类的创业模式我们称之为‘桃花源式的创业’。而大模型需要一些必须成功的要素,要有算力,要有钱;在中国,还必须要有政府支持。”某资本创始合伙人也并不看好。

可以看到,大模型的应用前景虽然非常广阔,但并不是所有企业和创业者都可以在这个领域取得成功,究其原因,从大模型的特点就可以看出来:

首先,大模型需要消耗大量的计算资源进行训练和优化,需要有足够的资金来支持,这对于任何一家企业都是巨大的挑战。

其次,大模型的开发和应用需要有一个相对稳定且强大的技术团队和管理团队,需要大把很贵且很有经验的人长期来进行调参和优化。一般的企业其组织和管理经验往往不是很足,很难长期顺利运行下去这样的项目。

再次,由于大模型的应用场景非常广泛,因此其需要有丰富的数据和场景来进行不断滋养,如果一个公司没什么用户基础和数据基础,很难训练得出来。

最后,虽然市面上大模型产品众多,但真正有能力做通用大模型的还是互联网大厂,根本原因是技术实力的不均衡。

与商业模式打法不同,大模型跑出来只能靠硬科技,大厂在大模型方面拥有先发优势,这种先发优势建立,会带动整体数据、算力以及商业“飞轮”,不断加固护城河,比如OpenAI就具有先发优势,国内要追赶上GPT3.5都还需时日。

二、领域大模型是成功关键

一位互联网人士分享了一个小故事——几天前,他曾遇见一帮创业青年,在交流的过程中,对方告诉他,他们搜集了一大堆修车相关的案例和知识,想问问他能不能提供通用大模型的能力基础,来帮助他们去训练一个修车行业的大模型出来,以便让中国1000万修车工都能拥有20年老师傅的功力。

“这是一个典型的行业的能力。”在他看来,今天有太多垂直领域,其实是ChatGPT等通用大模型解决不了的,例如面对修车问题,他们都只能泛泛而谈,“未来大模型这个产业怎么发展,我觉得还得往垂直化、产业化、企业化,甚至个人化发展”。

实际上,相关企业都已摩拳擦掌。互联网大厂百度、阿里纷纷官宣伙伴计划和工具链,声称要让每一个行业都能够用上自己的大模型。各行各业的龙头企业、创业公司,同样马力十足。金融、教育、医疗、自动驾驶、智能物流、安防等多个领域的行业公司都已相继传出要推行业大模型的消息。

可以预料,现在只要是上市公司或规模稍微大一点的企业,都会有自己的大模型,大模型的战事,已经开始从通用大模型,迅速卷向面向垂直领域的行业大模型。正如李彦宏先生所说:“未来所有的应用都将基于大模型来开发,每一个行业都应该有属于自己的大模型,大模型会催生AI原生应用。未来需要用AI原生思维重构所有的产品、服务和工作流程。”

为什么行业大模型或者说领域大模型会成为下一个风口呢?原因大概有四个。

1、通用大模型的能力限制

当大模型发展到一定阶段,很多企业发现,通用大模型虽然具备涌现的能力,但如果原始数据里一点行业数据都没有,那它对行业理解还是会存在局限性,其通用能力已无法承载更为专业的领域,比如医疗、金融等。

每一个领域都是独立的知识体系,具备极为庞杂的知识量,有大量沉默的行业数据,这些数据的价值,仅靠通用大模型无法满足垂直领域的需求,只有通过领域大模型才能激活并发挥出来。企业在自己擅长的领域训练适合自己的“产业版GPT”,这类大模型生成的内容会更符合特定垂类场景的需求,质量更高。

2、领域大模型的成本优势

从成本方面考量,通过通用大模型微调实现的领域大模型相较通用大模型是“几何级别的下降”。根据某证券的测算,在模型微调阶段,由于训练量级较小,仅为万级,相关的算力成本相比之下可忽略不计。

以斯坦福大学于2023年3月发布Alpaca为例,这是一个基于LLaMA-7B基座,应用5.2万指令对模型微调训练而来的对话类语言模型。该模型基于8块A100微调,微调时长3小时,算力成本不超过300元,现在甚至不需要微调大模型,通过集成LangChain等插件就可以实现轻量级的领域大模型。

3、国内软件的定制化习惯

第三方市场调研机构Gartner在2022年4月的一组数据显示,中国软件支出在IT支出中的占比仅为4.9%。相比之下,全球市场软件支出在IT支出中的占比为15.2%。中国IT支出结构特征就是硬件大于软件,定制化大于产品化。

中国数字化市场不像美国以公有云为主,而是公有云、混合云、私有云并存。这在SaaS/PaaS软件发展阶段就出现了明显分岔。这种分叉将会延续到了AI模型市场,定制化/私有化需求会占据较大比重,尤其在政府、金融、制造等市场。

4、大模型信息安全的考量

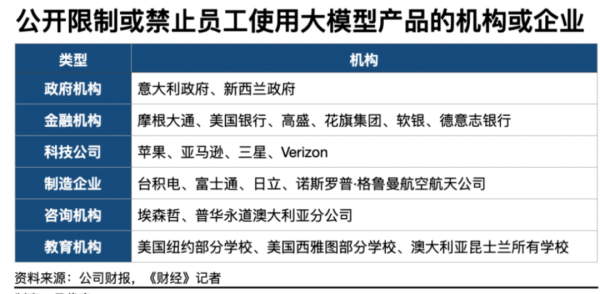

当前在海外市场,部分政府、金融机构、电信运营商、制造企业甚至是科技公司已经明确禁止或限制员工在工作场合使用ChatGPT等大模型产品。其中包括苹果、三星、摩根大通、花旗银行等知名企业。理由通常是,担心专利或机密资讯泄密、客户资料外流。

从技术逻辑来看,当企业在公开网络使用ChatGPT等跑在公有云上的大模型时,资料会被回传到云上用于模型的改善、调教。其他用户在输入类似内容时,可能会获取被上传的资料。

三、领域大模型的三大挑战

相对于通用大模型,虽然打造领域大模型的门槛和成本大大降低,但还是存在不少挑战。

1、开源大模型不太给力

领域大模型是在通用大模型基础上进行微调训练或通过提示词工程得到的,因此通用大模型的质量是领域大模型成功的基础,基于大多企业私有化部署的需要,私有化部署的通用大模型有三种实现方式:

第一、直接引入开源大模型,比如chatGLM。

第二、购买商业化的大模型。

第三、基于领域数据微调开源大模型。

但根据我们的测试和判断,当前的各种开源大模型(未开源的不得而知)离OpenAI的GPT3.5还有相当大的差距,基于这些开源大模型打造的领域大模型基本不可用,同时微调领域大模型需要企业有较高的技术能力,这进一步抬高了领域大模型的门槛。

2、缺乏高质量的领域数据

领域大模型强调垂直领域的Know-How,基础是领域大数据,即语料。

在质量方面,要求领域数据具有权威性,比如金融领域,一个信息的错误可能对征信带来截然相反的判断,在规模方面,要求保证质量的前提下,训练数据量越大,推理能力就越强;在多样性方面,要求训练数据集尽可能丰富、全面,能够提高模型泛化能力,过于单一的数据会非常容易让模型过于拟合训练数据;在及时性方面,要求实时更新的数据尽快得到利用。

很多传统企业或数字化刚起步的企业,大量语料数据都是非结构化的,散落在各个不同部门,没有什么现成的领域语料数据可供训练,领域数据的记录、盘点、采集、清洗和转化成为了前提条件,这实际上考验着企业的数据治理水平。如果贸然将未经筛选和处理的数据直接“喂给”大模型,则会严重影响领域大模型的训练效果。

3、缺乏快速落地的硬场景

现在搞领域大模型的玩家一个接着一个,但就目前来看,大多其实都还停留在讲概念、讲技术的阶段,好一点的在提炼需求,积累数据,还有一些虽然处于进行内部测试或项目定制的阶段,但离真正的商用距离很大。

要做好领域大模型,企业一方面要能找到合适的业务场景,从逻辑上讲,领域大模型一定会是在精度相对较低、容错率较高的领域先引用,再到精度要求高的地方去。另一方面还需整合AI、数据、技术等关键生产要素,这非常考验企业对大模型的认知水平、技术能力和组织能力。

企业也许应该成立一个大模型部门来专门推进,尽快在具备刚需的应用场景落地,形成自我造血的良性循环,不断自我进化、修正和完善。

四、领域大模型的实现方法

在当下的情况下,出于对成本、进入门槛和速度等的考虑,“开源大模型+自研小模型+垂直语料”大概率会成为接下来一个领域大模型的实现路径。

一方面,从事大模型开源的可能会越来越多;另一方面,在开源大模型的基础上去调试自己的领域大模型,会成为一个主流。这就像当初的Web服务器、数据库等互联网基础设施,最后在市场上留下来的,除了少量私有,其余绝大部分场景用的都是开源的。

但就现阶段而言,也不能对某个大模型依赖过重,毕竟战局还没有最后确认下来。这就好比10年前安卓、塞班、黑莓等一堆底层操作系统厂商在干架,一旦某家企业对某个操作系统过于依赖,后期它的方案又长期跟不上迭代,这家企业就会吃亏。

基于开源大模型做领域大模型的企业,在尽可能跟市场上这些开源大模型结合的同时,也要解耦。

第一种方案是用提示词的形式来对接,耦合度很低的,随便换一个模型,一下就能换掉。我们现在采用的就是类似的方案,即ChatGLM+LangChain,共分为五步:

1、搜集领域数据:把领域的相关文档资料进行收集,并转成文本文件

2、切分领域文本:把领域内容拆成一块块的小文件块,因为我们希望只向大模型传递最小的、最相关的文本块

3、创建嵌入文本:为每一块文本创建嵌入,并将它们存储在一个向量数据库中。这样就可以使用这些嵌入来查找与问题最相关的文本块

4、查找嵌入文本:这个时候就可以接受领域输入了,即Query,将这个问题转化成词嵌入的向量,然后查询前面的领域向量数据库,找到最相似的K个向量和对应的K个文本块

5、调用大模型回答:将K个相关的文档和问题作为上下文输入大模型,大模型就可以生成了一个结合了上下文的回答,这种回答不仅带有了领域的知识能力,而且能用人话给予回复。步骤1、2、3、4就是LangChain实现的功能,它成为了聊天应用与大模型的沟通桥梁。

以上方法不需要对大模型做任何变更,仅通过构建与问题相关的上下文来直接调用大模型,大模型再结合以前训练的知识库去做归纳、总结、推理,这是一种非常轻量化的实现方法。

第二种方案是基于领域数据对大模型进行fine-tuning,这样做的代价比较大,因为fine-tuning会尝试优化所有的参数,还可能导致模型过拟合。LoRA是新提出的一种方案,效果被认为是有希望的,因为LoRA只修改了一个相对较小的参数子集,可以在较小的硬件上进行微调,从而更好地避免过拟合问题。LoRA已经在ChatGPT中进行了应用,使用LoRA和DeepSpeed两种技术,可以在只使用65GB的显存的情况下,实现大型语言模型(LLMs)的训练优化。

第三种方案则是引入第三方模型服务,即MaaS,由于以上两种方法对企业的技术能力都有较高的要求,因此可以尝试借助外部力量。当前很多企业都把MaaS当为了行业大模型的新赛道,比如腾讯云TI平台,结合过去在文旅、金融、政务、教育等行业的需求洞察,封装成行业大模型解决方案提供给客户。企业可以在这些内置行业大模型基础上,加入自己独有的场景数据,快速生成自己的专属定制大模型。MaaS同时也提供了大模型工具链和配套服务,包括数据标注、训练、测试、评估、部署等全套工具,助力企业快速精调大模型。

可以肯定的是,未来能把领域大模型搞成功的,一定是那些拿到了高质量的领域数据,找到了最刚需业务场景的企业,领域大模型如果做得多了,就可以抽象成行业大模型,从而找到对外商业化的机会。

通用大模型作为领域大模型的基础,虽然很重要,但未来一定是基础设施般的存在(市场上也许只会剩下几家,现在基本上是“万事俱备只欠东风”,希望后续大厂给力啊),不会成为企业领域大模型的胜负手。