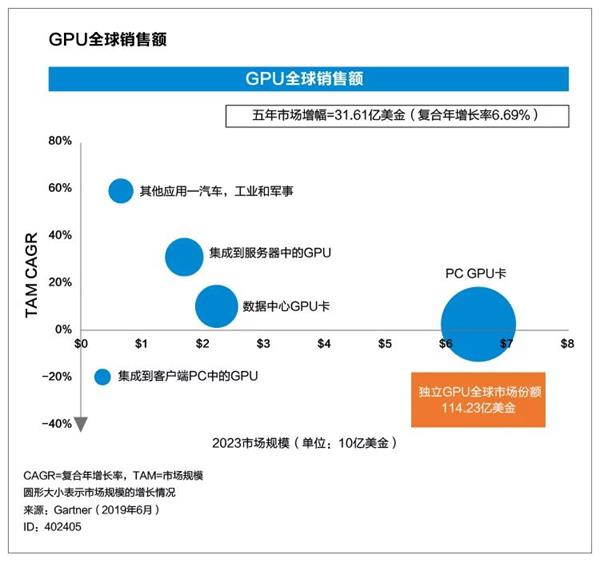

Gartner近日发布《全球GPU发展预测分析报告》,预测到2023年,GPU的市场销售额预计达到114.2亿美元,年复合增长率6.69%。

面向高性能游戏的PC

GPU仍然是市场的主要驱动力,到2023年,GPU的平均销售价将增长25%。与此同时,适用于数据中心、能够加快AI和数据科学工作负载运行速度的GPU表现出更强劲的增长势头,其年复合增长率预测将达到22.53%,到2023年,至少10%的服务器需配置GPU,以满足工作负载加速需求。

Part1 电脑游戏篇

为了打造身临其境的游戏体验,电脑游戏开发者们要为玩家实时渲染复杂的视觉影像。这通常是用性能强劲的GPU来实现的,包括通过PCIe接入的外插GPU,以及集成到PC主板上的GPU。推动性能强劲GPU需求增长的因素如下:

●屏幕分辨率从高清(HD;1920 x 1080像素)发展到超高清(UHD;3840 x 2160像素或4K)

●个人电脑支持多个高分辨率显示器

●渲染算法越来越复杂,例如实时光线追踪

1

到2023年,PC显卡中的GPU平均售价将比2018年提高25%

PC MPU的供应商们正在把GPU功能加入到微处理器的设计中,他们或是将计算和GPU功能要素集成到单个MPU芯片上,或是把GPU芯片集成在与MPU相同的包中。

这些集成了GPU的MPU能够提供充分的图形性能,以满足众多游戏玩家的需求。GPU集成技术的发展、市场对超级移动PC的青睐、传统台式机和笔记本电脑需求的降低,都导致了基于GPU的外插显卡市场规模下降。为了从一众竞争者中脱颖而出,维持市场占有率,GPU供应商们必须不断提高产品性能,而产品售价也会相应提高。受此影响,2018年到2023年,集成到PC显卡中的GPU平均售价将增加25%。

2

配备集成GPU的个人电脑百分比将从2018年的14%下降到2023年的6%

笔记本电脑和超级移动PC的OEM厂商已经开始在产品中使用GPU来增强其预集成MPU的GPU数量。

然而随着集成GPU性能的增强,以及PC的OEM厂商对延长电池使用寿命的诉求,许多笔记本电脑将在设计中减少GPU的配置需求(集成在MPU中的GPU除外)。这会对移动PC中GPU的数量预测产生负面影响。

Part2 数据中心篇

可用于解读和分析海量非结构化数据(视频内容、图像和音频数据)的新的软件应用程序正在被开发。许多这类应用程序都是基于各种深度神经网络(DNN)算法。虽然这些应用程序可以在标准MPU上运行,但使用高并行数字处理芯片以及异构MPU能够提高其处理效率。

虽然GPU最初是为图形处理而设计的,但其架构支持在大型数据点(像素)阵列上的并行数值计算。现有的GPU可以通过编程,对数据集进行一系列并行数值计算,使其更适合基于DNN的应用程序加速。为了支持这一应用场景,主流GPU供应商不仅为数据中心服务器量身打造了GPU PCIe外插卡,还为服务器供应商们提供了专为特定GPU服务器设计的GPU。这些用在服务器中的GPU集成了高带宽内存(HBM)和专用高速互连以提高数据吞吐量,远远超过游戏显卡的性能。

如今,大部分配置在服务器中的GPU是用于开发和训练AI模型的,并针对高性能和高数据吞吐量进行了优化,因此平均售价也比较高。随着AI市场的成熟,人们可以直接部署训练好的AI模型来进行新数据的分析和推理。用于推理工作负载优化的GPU性能要求比用于训练的GPU低,到2023年,这类GPU将成为服务器配置的主流。尽管用于推理的GPU平均售价比用于训练的GPU低,但前者的销量会大大高于后者。整体来说,数据中心服务器所配置的GPU平均售价将会降低。

1

到2023年,10%的服务器将配备GPU以加速工作负载,而这一数字在2018年还不到2%

随着越来越多的服务器集成了GPU,并且通过GPU提高特定工作负载的性能,应用程序开发人员们也将不断优化相应软件。

这种GPU优化的工作负载会密集产生大量数据,因此需要使用配备多个GPU的服务器,这些GPU既可以是集成到服务器中的,也可以是通过PCIe外插卡接入的。许多云和企业数据中心将会在现有服务器基础架构的基础上,另外部署GPU服务器,这也将成为GPU出货量增多的原因之一。

2

2019年到2023年,部署到服务器中的GPU平均售价将下降50%以上

目前,大部分部署到服务器中的GPU都是用作开发、训练AI算法和模型的。这些AI模型开发好后就可以被集成到软件应用程序中,进行大规模部署。AI模型的训练过程会密集产生大量数据,通常需要与超大规模数据集进行多次数据交互。例如,训练图像识别模型时可能需要多次处理数百万个高分辨率图像,这就需要用到专为此类任务设计的高性能GPU。

训练好的AI模型将被集成到软件应用程序中,在各种数据中心中进行大规模部署。在部署已经训练好的模型时,可以使用性能相对低一些(价格也比较便宜)的GPU。虽然现在大部分服务器使用的GPU售价较高,但是到了2023年,人们可以使用相对便宜的GPU进行部署,从而使服务器中配置的GPU平均售价显着下跌。

Part3 新玩家加入

2019-2023年,AI应用程序从开发、训练到部署、推理的转变会给新供应商们提供参与市场竞争的机会。一方面,GPU会被应用到大量部署中,另一方面,其他工作负载加速器的应用,如优化的CPU、现场可编程门阵列(FPGA)和专用应用集成电路(ASIC)也将推动GPU在数据中心市场中销量的增长。

在新工作负载部署的推动下,数据中心市场还在继续发展。由于GPU能够加快工作负载的运行速度,因此预测显示在未来几年,Intel的加入将促进市场增长。