就如同汽车制造行业的赛车一样,长期以来,高性能计算(HPC)领域一直是后来最终得以推广应用到主流计算领域的相关技术的试验场。实际上,今天的云系统和超大规模部署对于推动无虚构硬件,负载平衡文件系统和开源软件开发的高性能计算先驱企业们而言,可以说是欠下了太多。同时,这导致业界的相关人士也在开始探索目前应用于HPC的水冷趋势是否适用于主流数据中心。

简短的历史回顾

在当前的数据中心业界,使用水冷却方案作为冷空气的替代冷却方法已经再次兴起复苏。对于那些年纪太小刚刚进入数据中心行业的年轻从业人员们来说,他们或许并不知道水冷却方案曾经是数据中心最为主要的冷却方式,而且该方式目前仍然适用于大型主机。但随着上世纪90年代和2000年代以来,x86服务器架构的出现,空气冷却方案逐渐成为了事实上的新的冷却标准。

位于德国慕尼黑市的Leibniz-Rechenzentrum(LRZ)公司的超级计算中心是一处为来自世界各地的多元化研究人员们提供超级计算需求支持的计算中心,在2012年,该计算中心为HPC供应商社区带来了独特的挑战:LRZ公司希望能够在不牺牲计算性能的情况下大幅削减其电力资源的消耗。来自IBM 公司的System x团队提供了一款服务器,该服务器具有采用温水直接水冷却功能,可将未冷却的水直接连接到CPU,内存和其他高功耗组件。由此,温水冷却超级计算机的时代诞生了。

在过去,数据中心的水冷却方案一直都是采用冷水机组进行的。但在LRZ公司的计算中心,他们使用了高达45°C的未冷却水的受控回路。除了带来了能源效率的提升和数据中心级别的成本大幅节约之外,还带来了一些额外的好处。由于超高效的直接水冷却方案使得CPU保持更冷,因此处理器内的能量损失更少,比同类风冷处理器节省多达5%。如果需要的话,英特尔的CPU可以不断地以“turbo模式”运行,将性能额外的提升10-15%。因为服务器系统没有风扇,除了电源上的小风扇,使得操作几乎是无声的。数据中心产生的热水通过管道输送到建筑物中作为热源。而据LRZ公司称,借助采用该模式,其整体节能量接近40%。

今天的现状

几年过去后的今天,绝大多数(即使不是全部的话)主要的x86系统服务器供应商们都以某种方式选择了水冷却解决方案模式。这些x86服务器产品涵盖了水冷式后门热交换器,其作用类似于汽车的散热器,吸收空气冷却系统排出的热量,使得服务器产品直接浸没在充满特殊介电兼容冷却剂的储罐中——类似于大量鸡肉炸锅的服务器则负责充当加热组件。

直接水冷系统也在不断发展。现在,热材料的进步已经使得进水温度允许达到50°C。这使得水冷却方案几乎可以在世界上的任何地方使用,而无需使用冷水机组。此外,由水冷却的部件的数量也已经扩大:除CPU和内存外,现在IO和电压调节装置都是采用水冷的,进而推动了从系统到水的热量传输百分比超过了90%。

遗憾的是,并非数据中心的所有设备都可以采用水冷解决方案,因此LRZ公司和联想集团正在研究通过将热水“废物”转化为冷水来扩展替代冷却方案,这些冷水可以重复用于冷却数据中心的其余部分。这个过程使用“吸附式冷却器”,其从100台计算机架中取出热水,并将其传递到一片特殊的硅胶片上,蒸发水,对其进行冷却。由此,蒸发的水被冷凝回液体形态,然后要么通过管道回到计算服务器机架,或者要么进入后门热交换器,用于储存机架和联网装置,这些都不是水冷的。正是因为输送到冷却机组的水足够热,以使该过程得以高效运行,进而使得这种数据中心的设计方法成为了可能。服务器设备与数据中心基础设施之间的紧密连接和相互依赖性具有很大的潜力。

固然,拥有数千个节点,数PB级别的存储和数英里互连电缆的巨型超级计算机集群可能已经证明了数据中心转向采用水冷却基础设施的方案是成本合理的。那么对于那些主要是运行了企业的电子邮件系统、文件打印系统、CRM和其他必要的业务应用程序的一般的数据中心而言,是否需要尽快的雇佣水暖工以采用上述冷却方案呢?并非如此,但事实上,今天已经有一些因素会推动企业客户考虑在未来采用上述相关的替代冷却方法了,并且这些替代冷却方法的采用可能比大多数人预期的要早。

亟待处理的是数据中心的散热,而不是湿度

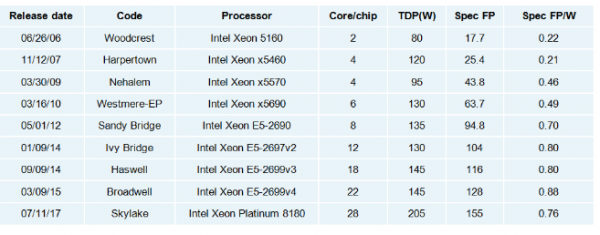

过去50年来,推动处理器领域不断创新背后的驱动力一直是摩尔定律,该定律指出:集成电路中的晶体管数量大约每两年增加一倍。而提出摩尔定律的英特尔公司每18个月就会将CPU性能提高一倍,同时成本将降低50%。然而,在半个世纪之后,对于这一预测的实现正变得越来越困难。为了保持摩尔定律曲线,英特尔公司必须为CPU增加更多的处理内核,这显然会消耗更多的功率,从而产生更多的热量。下表显示了英特尔处理器的功耗在过去十几年中是如何增长的:

为了处理应对这些散热,空气冷却环境中的处理器将需要更大(更高)的散热器,这将需要具有更高或更大底盘的系统。而根据美国采暖、制冷和空调工程师协会的估计,标准化机架中的热负荷将持续增加:

那些在过去20年中备受欢迎的1U“披萨盒”服务器最终是否会成为濒临灭绝的产品呢?可能不会,但与此同时,它们可能也不会像过去二十年那样得到大范围的部署了。简而言之,企业客户将面临一个艰难的权衡:系统密度(他们的IT人员可以塞进机架的服务器数量)与CPU能力(更少的内核数量)。那些希望运行更多内核CPU的企业客户将不得不放弃机架中的空间,这也就意味着其数据中心将需要安装更多的机架,进而也就意味着其包括房地产成本、电气费用和空调成本在内的运营费用(OPEX)将更高。

故而这些企业客户肯定不得不考虑采用替代的冷却方案来缓解这些问题。直接水冷系统不需要SUV大小的散热器。这将使得他们能够在不影响服务器计算性能的情况下保持其规模大小。

走向更加绿色环保的解决方案

第二个因素取决于您企业数据中心所处的地理位置。“绿色环保”数据中心的计划倡议已在欧洲实施了十年。该计划倡议促使LRZ和其他类似的企业纷纷积极的寻求采用空气冷却的替代品。TOP500.org网站上甚至还有一份“绿色环保500强”的清单,列出了最节能的数据中心。随着更多这些装置的完工和推广,其他相关企业客户可能会看到50%的电力成本节省和15%的性能提升,这足以证明采取水冷却方法的有效性。

目前,全球范围内,大约55%的电力供应来自对化石燃料的燃烧。而整个数据中心行业大约消耗了全球近3%的电力资源,故而整个数据中心行业在能源消耗方面不能再像“避开雷达的监控,偷偷飞入敌军领地”那般躲避监管了。相关的政府监管机构已经看到监督要求企业采用节能措施的必要性,并制定了相关的法律法规来强制企业降低数据中心的能耗。

数据中心采取更佳“绿色环保”的节能方案不仅仅是一种无私的努力。在许多地方,其也是必要的。目前,全球某些地区的电价可能已经超过了每千瓦时0.20美元,而在其他某些地区的价格甚至可能是这一数字的两倍。当前企业数据中心采用替代冷却方案的最大障碍是管道基础设施的前期成本和水冷系统较之空气冷却方案的小额溢价(在大多数情况下小于10%)。

企业的财务管理部门总是问,“这样的系统需要多长时间才能收回成本?”在某些情况下,可能需要一年时间。 当然,这些TCO和ROI取决于解决方案本身和安装成本,但大多数OEM厂商都有TCO计算器来帮助企业客户确定直接水冷系统的投资回报。

总结

毫无疑问,水冷系统已经在HPC中占有一席之地了。我们希望该方案将来能够扩展到常规的商业化数据中心。显然,大多数数据中心在目前还在采用Skylake处理器架构的时期都不会转换到采用水冷却方案。然而,随着遵守摩尔定律变得更加困难,替代冷却方案将逐渐获得吸引和关注度。许多企业客户将面临重大的权衡,他们将寻求最大化服务器性能和数据中心密度的选择。水冷却解决方案提供了一种方法,同时降低了企业数据中心的运营成本,并有助于燃烧更少量的煤。