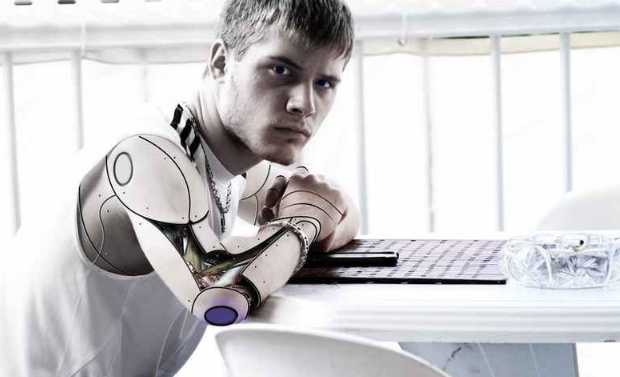

尽管这两年我国在“人工智能”领域发展突飞猛进,但是由于我国“人工智能”起步晚,仍然还处于初期阶段。人们所向往的是能够创造出能够弥补人类缺点的而并非毁灭人类的“人工智能”,它能够自己有自己独立的判断能力,能够说“NO”的机器人。

人类与人工智能互动的未来将会引发焦虑。随着人们开始推动将伦理观念输入到人工智能体系中,我们必须承认这样一个想法:我们需要制造出可以对命令说“不”的机器。

这么做的目的不仅仅是让机器人不对未识别的命令的做出回应,同时也是希望给机器人赋予这么一样能力——即在特定情况下,拒绝不合适、有用的人类命令。这一设想并不容易实现,对于某些人来说也很难接受。

尽管人工智能发展迅速,我们仍然处于这一大变革的开始阶段。许多复杂的人工智能系统还远远未达到能够独立做决定的阶段,在相当长的一段时间内,这些人工智能系统仍然只能一起工作或是在人类的指示下工作。 创造出能够弥补人类缺点、而非能毁灭人类的人工智能越来越被认为是这项技术完美的发展方向。但是,关键在于,这也意味着如果人工智能具备了伦理观念,它不仅会拒绝人类非法或不道德的命令,也能执行这些命令。

随着人工智能系统变得更加强大和普遍,他们是否会具备伦理观念这一问题变得突出起来。幸运地是,关于这一问题的研究在人工智能领域和学术界都很丰富。DeepMind这一由谷歌在2014年收购的伦敦人工智能研究组是最近想要发行具备伦理观念的机器人的研究组,他们邀请了来自不同领域的顾问,以帮助了解清楚由人工智能在社会上究竟扮演何种角色所引起的两难之境。但是随着我们不断探寻无人驾驶汽车深层次的决策制定过程,深思军用机器人是否能够得到允许以做出杀戮的决定,尝试发现植根于机器学习算法中的种族主义和性别歧视,我们需要退后一步,认识到我们努力做的东西具体情境和它的复杂性。

抵抗是有效的

在几乎所有情境下,由机器所做的决定可以追溯到由人提出的要求。如果机器想要具备伦理观念,它必须有能力识别一项请求是否是合乎道德,在某些情况下,它必须克制自己,不做决定。

人类并不完美。我们已经可以看到有一些观点认为军用机器人相比于人类,可以更好的决定是否摧毁一个目标。这样的想法认识到了人类可能会在做决定时犯认知性的错误。

与此类似,军用机器人不会参与到由愤怒或是厌恶驱使的暴行当中。但是,如果由人工智能控制的机器人被命令去攻击一个村庄呢?美国士兵受到的训练中就有识别和拒绝非法命令。军用人工智能也应当根据同样的规则来工作。

同样的规则适用于军事之外的领域。无论我们是在讨论一个批准或者拒绝贷款的金融机器人,努力避免危险路况的无人车,还是分发止痛药的医药机器人。一个得到购买机器人授权的人类用户,可能会引导人工智能做一些如果人类做会被认为是有问题、甚至是非法的事情,比如让少数群体更难获取贷款,走一条已经关闭或者是很危险的路,开过量的鸦片类药物。

除非人工智能可以识别并拒绝这类决定,否则的话,我们不过也就是打造另一个也会存在人类固有的缺点的智能机器世界,只不过在计算机客观性的掩饰下这个世界的阴暗面并不那么明显。

拒绝在某些时候可能具有侵犯性,但是具备伦理观念的人工智能的未来更加合理,这意味着我们会习惯知道什么时候说“不”的机器。

(原标题:观点:人类需要制造会“违抗命令”的人工智能)